وبلاگ / مدلهای پایه (Foundation Models): پایه و اساس نسل جدید هوش مصنوعی

مدلهای پایه (Foundation Models): پایه و اساس نسل جدید هوش مصنوعی

مقدمه

یک دانشجوی پزشکی که سالها علوم پایه مثل آناتومی، فیزیولوژی و بیوشیمی را فراگرفته است، برای تخصصی شدن در جراحی قلب نیازی ندارد دوباره تمام این علوم را از صفر یاد بگیرد؛ کافی است دانش تخصصی جراحی قلب را روی پایههای قوی قبلی خود بسازد. دقیقاً همین اتفاق در دنیای هوش مصنوعی با Foundation Models یا مدلهای پایه در حال رخ دادن است.

مدلهای پایه انقلابی در دنیای هوش مصنوعی ایجاد کردهاند که شیوه توسعه، استقرار و استفاده از سیستمهای هوشمند را کاملاً تغییر داده است. این مدلها با آموزش بر روی حجم عظیمی از دادههای متنوع، یک دانش عمومی و گسترده کسب میکنند که میتواند به راحتی برای صدها کاربرد مختلف تنظیم و بهینه شود. از ChatGPT که میلیونها نفر روزانه با آن گفتگو میکنند تا سیستمهای تشخیص پزشکی که جان انسانها را نجات میدهند، همه بر پایه این فناوری بنا شدهاند.

در این مقاله جامع، به بررسی عمیق مدلهای پایه، معماری آنها، نحوه کارکرد، کاربردهای شگفتانگیز و چالشهای پیش روی این فناوری خواهیم پرداخت. با ما همراه باشید تا دنیای جذاب این فناوری تحولآفرین را کشف کنیم.

مدلهای پایه چیست؟

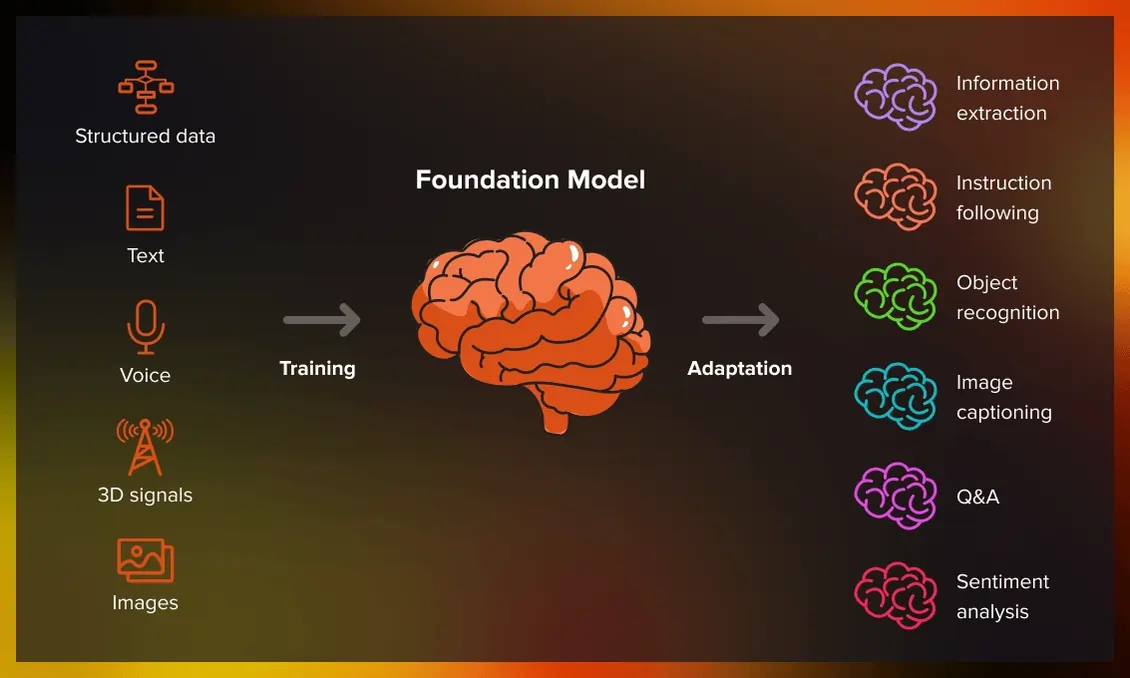

Foundation Models یا مدلهای پایه به مدلهای یادگیری ماشین بزرگ و قدرتمندی گفته میشود که بر روی حجم عظیمی از دادههای متنوع و بدون برچسب آموزش دیدهاند و قابلیت تطبیق با طیف گستردهای از وظایف مختلف را دارند. این مدلها به عنوان "پایه" یا "بنیان" برای ساخت سیستمهای هوش مصنوعی تخصصیتر عمل میکنند.

تفاوت اصلی مدلهای پایه با مدلهای سنتی یادگیری ماشین در این است که مدلهای قدیمی معمولاً برای یک کار خاص و با دادههای برچسبخوری شده آموزش میدیدند. مثلاً یک مدل فقط برای تشخیص گربه و سگ طراحی میشد و نمیتوانست کار دیگری انجام دهد. اما مدلهای پایه مثل یک دانشمند چندبعدی هستند که میتوانند در زمینههای مختلف فعالیت کنند.

ویژگیهای کلیدی مدلهای پایه

1. مقیاسپذیری عظیم: این مدلها معمولاً میلیاردها پارامتر دارند. برای مثال، GPT-3 دارای 175 میلیارد پارامتر است که آن را به یکی از بزرگترین شبکههای عصبی تاریخ تبدیل کرده است.

2. یادگیری خودنظارتی: این مدلها بدون نیاز به برچسبگذاری دستی دادهها آموزش میبینند. مثلاً یک مدل زبانی با پیشبینی کلمه بعدی در جمله، زبان را یاد میگیرد.

3. قابلیت انتقال دانش: توانایی استفاده از دانش آموخته شده در یک حوزه برای حل مسائل حوزههای دیگر - همان مفهوم Transfer Learning.

4. چندوظیفهای بودن: یک مدل پایه میتواند بدون تغییر معماری اصلی، برای کارهای متنوع مثل ترجمه، خلاصهسازی، تولید کد و تحلیل احساسات استفاده شود.

5. Emergence (ظهور قابلیتهای جدید): با افزایش اندازه مدل، قابلیتهای جدیدی به طور غیرمنتظره ظاهر میشوند که در مدلهای کوچکتر وجود نداشتند.

تاریخچه و تکامل مدلهای پایه

سفر به سمت مدلهای پایه از دهه 2010 شروع شد. در سال 2013، تکنیک Word2Vec معرفی شد که اولین گام مهم در یادگیری بازنماییهای معنایی کلمات بود. سپس در 2017، مقاله تاریخی "Attention is All You Need" منتشر شد که معماری Transformer را معرفی کرد - همان معماریای که پایه تمام مدلهای پایه امروزی است.

در 2018، BERT توسط گوگل معرفی شد و نشان داد که یک مدل pre-trained میتواند در دهها کار مختلف پردازش زبان طبیعی عملکرد فوقالعادهای داشته باشد. سپس GPT-2 و GPT-3 از OpenAI آمدند و توانایی شگفتانگیز تولید متن را به نمایش گذاشتند.

امروزه شاهد نسل جدیدی از مدلهای پایه هستیم که چندوجهی هستند - یعنی میتوانند با متن، تصویر، صدا و حتی ویدیو کار کنند. مدلهایی مثل GPT-4، Claude Sonnet 4.5، Gemini 2.5 Flash و DeepSeek V3 نمونههایی از این نسل پیشرفته هستند.

معماری و نحوه کار مدلهای پایه

مدلهای پایه معمولاً بر اساس معماری ترنسفورمر ساخته میشوند. این معماری دارای یک مکانیزم کلیدی به نام مکانیسم توجه است که به مدل اجازه میدهد روی بخشهای مهم ورودی تمرکز کند.

فرآیند Pre-training

Pre-training یا پیشآموزش مرحلهای است که مدل روی دادههای عظیم عمومی آموزش میبیند. در این مرحله:

برای مدلهای زبانی: مدل متنهای میلیاردی از اینترنت، کتابها، مقالات علمی و منابع دیگر را میخواند و سعی میکند کلمه بعدی در جمله را پیشبینی کند. این کار ساده به ظاهر، باعث میشود مدل درک عمیقی از زبان، دستور زبان، دانش دنیای واقعی و حتی استدلال منطقی پیدا کند.

برای مدلهای بینایی: مدل میلیونها تصویر را میبیند و یاد میگیرد اشیاء، الگوها، بافتها و روابط فضایی را تشخیص دهد. معماریهایی مثل Vision Transformers (ViT) در این زمینه کاربرد دارند.

برای مدلهای چندوجهی: مدل همزمان روی دادههای متنی و تصویری آموزش میبیند و یاد میگیرد ارتباط بین این دو حوزه را درک کند. این موضوع در مدلهای چندوجهی به تفصیل بررسی شده است.

فرآیند Fine-tuning

بعد از Pre-training، مدل برای کارهای خاص Fine-tune میشود. در این مرحله، مدل با دادههای کمتر اما تخصصیتر آموزش میبیند. مثلاً:

- یک مدل پایه زبانی را میتوان برای تشخیص و درمان پزشکی Fine-tune کرد

- همان مدل را میتوان برای تحلیل مالی تنظیم کرد

- یا برای تولید کد برنامهنویسی بهینهسازی کرد

تکنیکهای مدرن Fine-tuning مثل LoRA و QLoRA این فرآیند را بسیار کارآمدتر کردهاند و نیاز به منابع محاسباتی را کاهش دادهاند.

مهندسی پرامپت: استفاده بدون Fine-tuning

یکی از جذابترین ویژگیهای مدلهای پایه این است که میتوان بدون هیچ آموزش اضافی، فقط با طراحی دقیق سؤال یا دستور (Prompt)، کارهای پیچیدهای از آنها گرفت. مهندسی پرامپت به یک مهارت حیاتی تبدیل شده که با آن میتوان بهترین خروجی را از مدلهای پایه استخراج کرد.

انواع مدلهای پایه

| نوع مدل | کاربرد اصلی | نمونههای معروف |

|---|---|---|

| مدلهای زبانی (LLM) | پردازش و تولید متن، گفتگو، ترجمه | GPT-4, Claude, Gemini, DeepSeek |

| مدلهای بینایی | تشخیص تصویر، طبقهبندی، segmentation | CLIP, DINOv2, SAM |

| مدلهای تولید تصویر | تولید تصویر از متن یا تصویر | DALL-E, Midjourney, Stable Diffusion, Flux |

| مدلهای تولید ویدیو | تولید ویدیوهای واقعگرایانه | Sora, Veo, Kling |

| مدلهای صوتی | تشخیص و تولید گفتار | Whisper, AudioLM |

| مدلهای چندوجهی | کار با متن، تصویر، صدا و ویدیو | GPT-4V, Gemini Pro, Claude 3 |

مدلهای زبانی بزرگ (LLM)

مدلهای زبانی محبوبترین نوع مدلهای پایه هستند. این مدلها روی میلیاردها کلمه آموزش دیدهاند و میتوانند:

- متن تولید کنند: از نوشتن شعر و داستان گرفته تا تولید مقالات تخصصی

- سؤالات را پاسخ دهند: مثل یک دانشنامه زنده که به هر سؤالی پاسخ میدهد

- ترجمه کنند: ترجمه دقیق و روان بین صدها زبان

- کد بنویسند: از کدهای ساده تا برنامههای پیچیده

- خلاصهسازی کنند: فشرده کردن متنهای طولانی به چند خط کلیدی

مدلهای بینایی

این مدلها روی میلیونها تصویر آموزش دیدهاند و میتوانند:

- اشیاء را تشخیص دهند: از تشخیص چهره تا شناسایی بیماریها در تصاویر پزشکی

- تصاویر را طبقهبندی کنند: دستهبندی محصولات، تشخیص کیفیت و غیره

- Segmentation انجام دهند: جداسازی دقیق اشیاء در تصویر

کاربردهای واقعی این مدلها را در پردازش تصویر با هوش مصنوعی و بینایی ماشین میتوانید بررسی کنید.

مدلهای تولیدی

این مدلها با استفاده از تکنیکهایی مثل Diffusion Models و GAN میتوانند:

- تصاویر هنری بسازند: Midjourney، Flux و GPT Image-1

- ویدیوهای واقعگرایانه تولید کنند: Sora 2، Kling و Veo 3

- محتوای خلاقانه بسازند: برای تبلیغات، موسیقی و هنر

کاربردهای شگفتانگیز مدلهای پایه

1. پزشکی و سلامت

تصور کنید یک دکتر که 24 ساعته در دسترس است، میلیونها مقاله پزشکی را خوانده و میتواند تصاویر MRI و CT-Scan را با دقت فوقالعاده تحلیل کند. مدلهای پایه این امکان را فراهم کردهاند:

- تشخیص زودهنگام سرطان: مدلهای بینایی میتوانند تومورها را در مراحل اولیه که برای چشم انسان نامرئی هستند، تشخیص دهند

- کشف داروی جدید: مدلها میتوانند میلیونها ترکیب شیمیایی را شبیهسازی کنند و داروهای امیدوارکننده را پیدا کنند - موضوعی که در کشف دارو با هوش مصنوعی بررسی شده

- تشخیص بیماری از روی علائم: یک مدل زبانی میتواند با تحلیل علائم بیمار، تشخیصهای احتمالی را پیشنهاد دهد

- پژوهش ژنتیک: کمک به درک بیماریهای ژنتیکی از طریق ژنتیک انسانی و هوش مصنوعی

2. آموزش و یادگیری

یک معلم شخصی که برای هر دانشآموز برنامه آموزشی منحصربهفردی طراحی میکند:

- یادگیری شخصیسازی شده: مدل میفهمد شما در چه قسمتی ضعف دارید و تمرینهای مناسب ارائه میدهد

- ترجمه لحظهای: دانشآموزان میتوانند منابع علمی به هر زبانی را بخوانند

- تولید محتوای آموزشی: تولید خودکار تست، سؤال و پاسخهای تشریحی

- کمک به معلمان: ارزیابی خودکار تکالیف و ارائه بازخورد سازنده

تأثیر گسترده این فناوری را در هوش مصنوعی و آینده آموزش میتوانید مطالعه کنید.

3. کسبوکار و مدیریت

- تحلیل مشتری: درک عمیق از نیازها و رفتار مشتریان برای بهبود تجربه کاربری

- خودکارسازی خدمات مشتری: چتباتهای هوشمند که میتوانند 95% سؤالات را پاسخ دهند

- پیشبینی بازار: مدلهای پیشبینی مالی که روندهای آینده را تحلیل میکنند

- بهینهسازی زنجیره تامین: پیشبینی تقاضا و مدیریت موجودی

- استخدام هوشمند: استفاده از هوش مصنوعی در استخدام برای یافتن بهترین نامزدها

4. خلاقیت و هنر

- طراحی گرافیک: تولید لوگو، پوستر و تصاویر تبلیغاتی در چند ثانیه

- تولید موسیقی: ساخت آهنگهای اورجینال با سبکهای مختلف

- نویسندگی: کمک به نویسندگان در تولید محتوا

- طراحی مد: هوش مصنوعی در صنعت مد برای پیشبینی ترندها و طراحی لباس

5. امنیت و دفاع

- تشخیص تهدیدات سایبری: امنیت سایبری با هوش مصنوعی

- تحلیل دادههای امنیتی: پردازش میلیونها رخداد امنیتی در لحظه

- تشخیص چهره: تشخیص چهره برای امنیت

- پیشبینی بحران: کمک به مدیریت بحران

- حملونقل و خودروسازی

- خودروهای خودران: استفاده در صنعت خودرو

- بهینهسازی مسیر: پیدا کردن بهترین مسیر با توجه به ترافیک و شرایط جوی

- نگهداری پیشبینانه: تشخیص قطعات آسیبدیده قبل از خرابی

مقایسه مدلهای پایه با رویکردهای دیگر

| ویژگی | مدلهای سنتی | مدلهای پایه |

|---|---|---|

| حجم داده آموزشی | هزاران تا میلیونها نمونه | میلیاردها نمونه |

| تعداد پارامترها | هزاران تا میلیونها | میلیاردها پارامتر |

| هزینه آموزش | پایین تا متوسط | بسیار بالا (میلیونها دلار) |

| تخصص وظیفه | یک کار خاص | چندین کار متنوع |

| نیاز به داده برچسبخورده | بله، حجم زیاد | خیر (self-supervised) |

| قابلیت انتقال دانش | محدود | عالی |

| عملکرد در وظایف جدید | نیاز به آموزش مجدد | سریع با Fine-tuning کم |

| دسترسی | نیاز به توسعه داخلی | API و ابزارهای آماده |

تکنیکهای بهینهسازی مدلهای پایه

1. انتقال دانش

Knowledge Distillation تکنیکی است که در آن یک مدل بزرگ (معلم) دانش خود را به یک مدل کوچکتر (شاگرد) منتقل میکند. این کار باعث میشود:

- مدل کوچکتر با سرعت بیشتری اجرا شود

- نیاز به حافظه کمتر شود

- هزینه استقرار کاهش یابد

2. Quantization و Pruning

این تکنیکها برای کاهش اندازه مدل بدون کاهش قابل توجه دقت استفاده میشوند:

- Quantization: کاهش دقت اعداد از 32-bit به 8-bit یا حتی 4-bit

- Pruning: حذف وزنهای کماهمیت از شبکه

این موارد در بهینهسازی هوش مصنوعی به تفصیل توضیح داده شدهاند.

3. Mixture of Experts (MoE)

Mixture of Experts معماریای است که در آن فقط بخشی از مدل برای هر ورودی فعال میشود، که باعث کاهش هزینه محاسباتی میشود.

4. Flash Attention

Flash Attention الگوریتم بهینهسازی شدهای برای مکانیزم Attention است که سرعت آن را چندین برابر افزایش میدهد.

5. Sparse Attention

Sparse Attention به جای محاسبه توجه بین تمام توکنها، فقط روی بخشهای مهم تمرکز میکند و محاسبات را کاهش میدهد.

استفاده از مدلهای پایه: Fine-tuning در مقابل RAG در مقابل مهندسی پرامپت

وقتی میخواهید از یک مدلهای پایه برای کاربرد خاص استفاده کنید، سه رویکرد اصلی دارید:

1. Fine-tuning

آموزش اضافی مدل روی دادههای تخصصی شما. مناسب زمانی که:

- دادههای زیادی دارید (هزاران نمونه)

- نیاز به عملکرد بسیار بالا دارید

- میخواهید مدل سبک و رفتار خاصی یاد بگیرد

2. RAG (Retrieval-Augmented Generation)

RAG رویکردی است که در آن مدل به پایگاه دانش خارجی دسترسی دارد و میتواند اطلاعات را از آنجا بازیابی کند. مناسب زمانی که:

- دادهها مرتب بهروز میشوند

- نیاز به پاسخهای مبتنی بر اسناد دارید

- میخواهید منابع پاسخها را ردیابی کنید

3. مهندسی پرامپت

طراحی دقیق دستورالعملها برای مدل. مناسب زمانی که:

- سریع نیاز به نتیجه دارید

- داده زیادی برای Fine-tuning ندارید

- میخواهید روی چندین کار متفاوت کار کنید

مقایسه کامل این سه روش را در Fine-tuning vs RAG vs Prompt Engineering مطالعه کنید.

چالشها و محدودیتهای مدلهای پایه

1. هزینه محاسباتی بالا

آموزش یک مدلهای پایه میتواند میلیونها دلار هزینه داشته باشد. برای مثال، آموزش GPT-3 تقریباً 4.6 میلیون دلار هزینه داشت. همچنین استفاده از این مدلها نیاز به سختافزار قدرتمند دارد.

راهحل: استفاده از مدلهای زبانی کوچک (SLM) برای کاربردهای خاص، یا استفاده از چیپهای اختصاصی هوش مصنوعی.

2. Hallucination (توهم)

گاهی مدلها اطلاعات نادرست اما قانعکنندهای تولید میکنند. این توهمزنی هوش مصنوعی یکی از بزرگترین چالشهاست.

راهحل: استفاده از RAG برای اتکا به منابع معتبر، یا استفاده از مدلهای استدلالی مثل O3 Mini که قبل از پاسخ، فکر میکنند.

3. سوگیری و تبعیض

مدلها ممکن است سوگیریهای موجود در دادههای آموزشی را تقویت کنند. این موضوع در اخلاق در هوش مصنوعی بحث شده است.

4. عدم شفافیت

این مدلها اغلب مثل یک "جعبه سیاه" عمل میکنند و نمیدانیم دقیقاً چگونه به یک نتیجه رسیدهاند. هوش مصنوعی قابل تفسیر سعی دارد این مشکل را حل کند.

5. محدودیت طول زمینه

بیشتر مدلها نمیتوانند متون بسیار طولانی را پردازش کنند. هرچند مدلهای جدید مثل Claude Sonnet 4.5 با پنجره زمینه بزرگتر این محدودیت را کاهش دادهاند.

6. امنیت و حریم خصوصی

- تزریق پرامپت: تزریق دستور مخرب در ورودی مدل

- نشت اطلاعات: احتمال افشای اطلاعات حساس از دادههای آموزشی

- سوءاستفاده: استفاده از مدلها برای اهداف مخرب

راهحل: استفاده از یادگیری فدرال برای حفظ حریم خصوصی.

7. محدودیتهای زبانی

مدلهای پایه معمولاً در زبانهای پرکاربرد مثل انگلیسی عملکرد بهتری دارند و در زبانهای با منابع کمتر مثل فارسی ضعیفترند. محدودیتهای مدلهای زبانی این موضوع را بررسی میکند.

آینده مدلهای پایه

1. مدلهای خودبهبود

مدلهای خودبهبود و Self-Rewarding Models نسل بعدی هستند که میتوانند بدون نیاز به داده جدید، خودشان را بهبود دهند.

2. AGI (هوش مصنوعی عمومی)

مدلهای پایه گام مهمی به سمت AGI هستند - هوشی که در تمام زمینهها مثل انسان یا بهتر عمل کند. زندگی پس از AGI میتواند دنیا را کاملاً متحول کند.

3. World Models

World Models مدلهایی هستند که مدل ذهنی کاملی از دنیای واقعی دارند و میتوانند آینده را شبیهسازی کنند.

4. مدلهای چندعاملی

سیستمهای چندعاملی که در آن چندین مدلهای پایه با هم همکاری میکنند. فریمورکهایی مثل LangChain، CrewAI و AutoGen این امکان را فراهم میکنند.

5. Physical AI

Physical AI ترکیب مدلهای پایه با رباتیک برای تعامل با دنیای فیزیکی.

6. Agentic AI

Agentic AI و AI Agent مدلهایی هستند که میتوانند به طور مستقل برنامهریزی کنند، تصمیم بگیرند و اقدام کنند.

7. محاسبات کوانتومی و هوش مصنوعی

هوش مصنوعی کوانتومی میتواند سرعت آموزش و استنتاج مدلها را به طور تصاعدی افزایش دهد.

8. یادگیری مستمر

Continual Learning به مدلها اجازه میدهد بدون فراموش کردن دانش قبلی، چیزهای جدید یاد بگیرند.

ابزارها و فریمورکهای کار با مدلهای پایه

برای کار با مدلهای پایه، ابزارهای متنوعی در دسترس هستند:

فریمورکهای یادگیری عمیق

- TensorFlow: فریمورک قدرتمند گوگل

- PyTorch: محبوبترین فریمورک در تحقیقات

- Keras: API ساده برای مبتدیان

پلتفرمهای ابری

- Google Cloud AI: ابزارهای هوش مصنوعی گوگل

- Azure AI: خدمات مایکروسافت

- AWS SageMaker: پلتفرم آمازون

ابزارهای No-Code

- Google Opal: ساخت اپلیکیشن بدون کد

- Google AntiGravity: محیط توسعه Agentic

مدلهای پایه و تحول صنایع

تحول در کسبوکار

مدلهای پایه در حال تغییر بنیادین نحوه انجام کسبوکار هستند:

- بازاریابی دیجیتال: تولید محتوا، تحلیل مشتری، بهینهسازی تبلیغات

- خدمات مشتری: پاسخگویی 24/7 با کیفیت بالا

- تحلیل داده: استخراج بینش از حجم عظیم داده

- مدیریت تیم: بهبود بهرهوری و همکاری

تحول در فناوری

- مرورگرهای هوشمند: اتوماسیون وب با هوش مصنوعی

- ساخت اپلیکیشن: توسعه سریعتر با کمک هوش مصنوعی

- Web 4.0: وب هوشمند آینده

تحول در جامعه

- شهرهای هوشمند: بهینهسازی شهری با هوش مصنوعی

- خانه هوشمند: زندگی راحتتر و امنتر

- کشاورزی هوشمند: افزایش تولید غذا

- محیط زیست: حفاظت از طبیعت

نتیجهگیری

مدلهای پایه بدون شک یکی از مهمترین پیشرفتهای تاریخ فناوری هستند. این مدلها نه تنها شیوه کار با هوش مصنوعی را متحول کردهاند، بلکه در حال تغییر بنیادین صنایع، مشاغل و حتی نحوه تعامل انسانها با تکنولوژی هستند.

از پزشکی شخصیسازی شده تا خودروهای خودران، از آموزش انفرادی تا هنر دیجیتال، مدلهای پایه در حال باز تعریف مرزهای ممکن هستند.

با این حال، با این پیشرفتهای شگفتانگیز، چالشهایی مثل اعتمادپذیری، اخلاق، تأثیر بر اشتغال و حریم خصوصی نیز پیش روی ماست که باید با دقت به آنها پرداخته شود.

آینده هوش مصنوعی به سمت AGI و حتی ASI (ابرهوش مصنوعی) در حرکت است. مدلهای پایه پایه این سفر هیجانانگیز هستند و ما فقط در ابتدای راه قرار داریم.

برای کسانی که میخواهند در این حوزه فعالیت کنند، فرصتهای بیشماری وجود دارد - از ایدههای استارتاپی گرفته تا کسب درآمد از هوش مصنوعی. آینده متعلق به کسانی است که این فناوری را درک کنند و بتوانند از آن به نفع بشریت استفاده کنند.

✨

با دیپفا، دنیای هوش مصنوعی در دستان شماست!!

🚀به دیپفا خوش آمدید، جایی که نوآوری و هوش مصنوعی با هم ترکیب میشوند تا دنیای خلاقیت و بهرهوری را دگرگون کنند!

- 🔥 مدلهای زبانی پیشرفته: از Dalle، Stable Diffusion، Gemini 2.5 Pro، Claude 4.5، GPT-5 و دیگر مدلهای قدرتمند بهرهبرداری کنید و محتوای بینظیری خلق کنید که همگان را مجذوب خود کند.

- 🔥 تبدیل متن به صدا و بالتصویر: با فناوریهای پیشرفته ما، به سادگی متنهای خود را به صدا تبدیل کنید و یا از صدا، متنهای دقیق و حرفهای بسازید.

- 🔥 تولید و ویرایش محتوا: از ابزارهای ما برای خلق متنها، تصاویر و ویدئوهای خیرهکننده استفاده کنید و محتوایی بسازید که در یادها بماند.

- 🔥 تحلیل داده و راهکارهای سازمانی: با پلتفرم API ما، تحلیل دادههای پیچیده را به سادگی انجام دهید و بهینهسازیهای کلیدی برای کسبوکار خود را به عمل آورید.

✨ با دیپفا، به دنیای جدیدی از امکانات وارد شوید! برای کاوش در خدمات پیشرفته و ابزارهای ما، به وبسایت ما مراجعه کنید و یک قدم به جلو بردارید:

کاوش در خدمات مادیپفا همراه شماست تا با ابزارهای هوش مصنوعی فوقالعاده، خلاقیت خود را به اوج برسانید و بهرهوری را به سطحی جدید برسانید. اکنون وقت آن است که آینده را با هم بسازیم!