وبلاگ / مدل ترنسفورمر: انقلاب در یادگیری عمیق و هوش مصنوعی

مدل ترنسفورمر: انقلاب در یادگیری عمیق و هوش مصنوعی

مقدمه

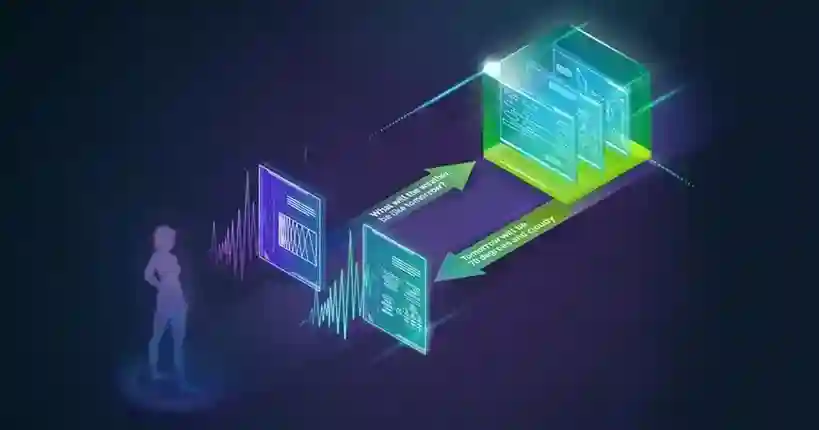

مدل ترنسفورمر (Transformer) یکی از مهمترین پیشرفتهای حوزه یادگیری عمیق است که در سال 2017 توسط محققان گوگل در مقاله "Attention is All You Need" معرفی شد. این معماری با استفاده از مکانیزم توجه (Attention Mechanism) توانست محدودیتهای اساسی مدلهای قبلی را برطرف کند و انقلابی در پردازش زبان طبیعی، بینایی ماشین و بسیاری از حوزههای دیگر ایجاد کند.

تفاوت اصلی ترنسفورمر با مدلهای سنتی مانند RNN و LSTM در نحوه پردازش دادههای متوالی است. در حالی که مدلهای قدیمی مجبور بودند دادهها را به ترتیب و یکی پس از دیگری پردازش کنند، ترنسفورمر میتواند تمام دادهها را به صورت موازی بررسی کند. این ویژگی نه تنها سرعت پردازش را چندین برابر میکند، بلکه امکان یادگیری ارتباطات پیچیدهتر میان دادهها را نیز فراهم میآورد.

امروزه تقریباً تمام مدلهای زبانی پیشرفتهای که با آنها در تعامل هستیم - از ChatGPT گرفته تا Claude، Gemini و Llama - همگی بر پایه معماری ترنسفورمر ساخته شدهاند. این مدلها توانستهاند در وظایف متنوعی از ترجمه ماشینی و تولید متن گرفته تا تحلیل احساسات و پاسخ به سوالات، عملکردی فراتر از انتظارات از خود نشان دهند.

تاریخچه و انگیزه ایجاد ترنسفورمر

پیش از معرفی ترنسفورمر، شبکههای عصبی بازگشتی (RNN) و نسخه پیشرفتهتر آن یعنی LSTM، استاندارد پردازش دادههای متوالی بودند. این مدلها با وجود موفقیتهای نسبی، مشکلات جدی داشتند:

مشکل گرادیان محو و انفجار: در جملات طولانی، اطلاعات کلمات ابتدایی به تدریج در طول پردازش از بین میرفت. این پدیده باعث میشد مدل نتواند ارتباطات بلندمدت را به خوبی یاد بگیرد.

عدم امکان پردازش موازی: به دلیل ماهیت متوالی این مدلها، نمیشد از قدرت پردازشگرهای گرافیکی (GPU) به طور کامل استفاده کرد. هر کلمه باید منتظر میماند تا کلمه قبلی پردازش شود.

کندی در آموزش: آموزش مدلهای RNN بر روی مجموعه دادههای بزرگ زمانبر و پرهزینه بود.

محدودیت در حافظه بلندمدت: حتی LSTM که برای حل مشکل حافظه طراحی شده بود، در جملات خیلی طولانی (مثلاً چند صد کلمه) دچار مشکل میشد.

محققان گوگل با درک این محدودیتها، به دنبال راهکاری بودند که بتواند:

- تمام کلمات یک جمله را به طور همزمان بررسی کند

- ارتباطات بین کلمات دور از هم را به خوبی مدل کند

- از پردازش موازی GPUها بهره ببرد

- قابلیت مقیاسپذیری به مدلهای بسیار بزرگ را داشته باشد

نتیجه این تلاشها، معماری ترنسفورمر بود که تنها با اتکا به مکانیزم توجه، توانست تمام این اهداف را محقق کند.

مکانیزم توجه: قلب ترنسفورمر

مکانیزم توجه ایدهای است که از نحوه عملکرد توجه انسان الهام گرفته شده است. وقتی شما یک جمله میخوانید، به طور خودکار به کلمات مهم بیشتر توجه میکنید و ارتباط هر کلمه را با سایر کلمات در نظر میگیرید. مکانیزم توجه همین کار را برای مدلهای هوش مصنوعی انجام میدهد.

نحوه عملکرد مکانیزم توجه

فرض کنید جمله "گربه روی پشتبام نشست" را داریم. وقتی مدل میخواهد معنی کلمه "نشست" را درک کند، باید بداند که چه کسی نشسته و کجا نشسته است. مکانیزم توجه این ارتباطات را به صورت زیر پیدا میکند:

برای هر کلمه، سه بردار محاسبه میشود:

- Query (پرسوجو): نشاندهنده "این کلمه به دنبال چه چیزی است؟"

- Key (کلید): نشاندهنده "این کلمه چه اطلاعاتی ارائه میدهد؟"

- Value (مقدار): اطلاعات واقعی که این کلمه حمل میکند

سپس مدل برای هر جفت کلمه، میزان ارتباط آنها را با محاسبه شباهت بین Query یک کلمه و Key کلمات دیگر محاسبه میکند. این میزان ارتباط را امتیاز توجه (Attention Score) مینامیم.

به عنوان مثال، وقتی مدل کلمه "نشست" را بررسی میکند:

- با "گربه" ارتباط قوی دارد (چون فاعل جمله است)

- با "پشتبام" ارتباط متوسط دارد (چون مکان است)

- با "روی" ارتباط ضعیف دارد (چون کلمه ربطی کمککننده است)

در نهایت، نمایش جدید کلمه "نشست" از ترکیب وزندار Value تمام کلمات به دست میآید، جایی که وزنها همان امتیازهای توجه هستند. این فرآیند به مدل اجازه میدهد تا درک عمیقتری از معنی هر کلمه در بافت جمله داشته باشد.

توجه چندسر (Multi-Head Attention)

یکی از نوآوریهای کلیدی ترنسفورمر، استفاده از توجه چندسر است. به جای اینکه فقط یک نوع توجه داشته باشیم، ترنسفورمر از چندین مکانیزم توجه موازی (معمولاً 8 یا 16 سر) استفاده میکند که هر کدام جنبه متفاوتی از ارتباطات را میآموزند.

برای مثال، در جمله "دختری که در پارک بود، توپ را به پسر داد":

- سر اول ممکن است بر روی ارتباطات دستوری تمرکز کند (فاعل-فعل-مفعول)

- سر دوم روی ارتباطات معنایی (دختر-توپ-پسر)

- سر سوم روی کلمات ربط و حروف اضافه

- سر چهارم روی ارتباطات زمانی و موقعیتی

این تنوع در نگاه به متن، باعث میشود مدل درک جامعتری از جمله داشته باشد و بتواند الگوهای پیچیدهتری را یاد بگیرد.

Self-Attention در مقابل Cross-Attention

دو نوع اصلی از مکانیزم توجه در ترنسفورمرها وجود دارد:

Self-Attention (توجه خودکار): هر کلمه به سایر کلمات همان جمله توجه میکند. این نوع توجه به مدل کمک میکند تا روابط داخلی متن را درک کند.

Cross-Attention (توجه متقاطع): در وظایفی مانند ترجمه ماشینی، کلمات زبان مقصد به کلمات زبان مبدأ توجه میکنند. این به مدل اجازه میدهد تا هنگام تولید هر کلمه، به کل جمله ورودی دسترسی داشته باشد.

ساختار کامل ترنسفورمر

معماری ترنسفورمر اصلی شامل دو بخش اصلی است: رمزگذار (Encoder) و رمزگشا (Decoder). اما در مدلهای مدرن، ممکن است فقط از یکی از این دو استفاده شود.

رمزگذار (Encoder)

رمزگذار وظیفه فهمیدن و تحلیل ورودی را بر عهده دارد. هر لایه رمزگذار از دو بخش اصلی تشکیل شده:

1. لایه Self-Attention: این لایه به هر کلمه اجازه میدهد تا به تمام کلمات جمله توجه کند و ارتباطات بینشان را درک کند.

2. شبکه Feed-Forward: پس از اینکه توجه اعمال شد، یک شبکه عصبی ساده (دو لایه با تابع فعالسازی ReLU یا GELU) روی هر کلمه به طور مستقل اعمال میشود. این شبکه الگوهای پیچیدهتر را یاد میگیرد.

بین این لایهها، دو تکنیک مهم استفاده میشود:

- Residual Connections: خروجی هر لایه به ورودی آن اضافه میشود تا از محو شدن گرادیان جلوگیری شود

- Layer Normalization: نرمالسازی دادهها برای پایداری آموزش

معمولاً رمزگذار از 6 تا 24 لایه تشکیل شده است که روی هم قرار میگیرند. هر لایه، درک عمیقتری از متن ایجاد میکند.

رمزگشا (Decoder)

رمزگشا وظیفه تولید خروجی را بر عهده دارد. هر لایه رمزگشا شامل سه بخش است:

1. Masked Self-Attention: شبیه به Self-Attention رمزگذار، اما با این تفاوت که هر کلمه فقط میتواند به کلمات قبل از خود توجه کند، نه کلمات بعدی. این برای جلوگیری از "دیدن آینده" در هنگام تولید متن است.

2. Cross-Attention: این لایه به رمزگشا اجازه میدهد تا به خروجی رمزگذار توجه کند. مثلاً در ترجمه، هنگام تولید هر کلمه فارسی، به تمام کلمات انگلیسی ورودی دسترسی دارد.

3. شبکه Feed-Forward: مشابه رمزگذار.

مدلهای Encoder-Only، Decoder-Only و Encoder-Decoder

با گذشت زمان، محققان دریافتند که بسته به کاربرد، میتوان فقط از بخشی از ترنسفورمر استفاده کرد:

مدلهای Encoder-Only (مانند BERT): برای وظایفی که نیاز به درک عمیق متن دارند، مثل دستهبندی، تشخیص موجودیتهای نامگذاری شده، و پاسخ به سوالات. این مدلها میتوانند به کل جمله دوطرفه توجه کنند.

مدلهای Decoder-Only (مانند GPT): برای تولید متن. این مدلها فقط میتوانند به کلمات قبلی توجه کنند و برای تولید متوالی بهینه شدهاند. امروزه بیشتر مدلهای زبانی بزرگ از این نوع هستند.

مدلهای Encoder-Decoder (مانند T5): برای وظایفی که نیاز به تبدیل ورودی به خروجی دارند، مثل ترجمه ماشینی و خلاصهسازی متن.

Positional Encoding: چگونه ترنسفورمر ترتیب کلمات را میفهمد؟

یکی از چالشهای اصلی ترنسفورمر این است که برخلاف RNN، هیچ اطلاعاتی درباره ترتیب کلمات ندارد. وقتی تمام کلمات به طور موازی پردازش میشوند، مدل نمیداند "گربه سگ را دید" با "سگ گربه را دید" چه تفاوتی دارد.

برای حل این مشکل، Positional Encoding استفاده میشود. این تکنیک یک بردار خاص به هر کلمه اضافه میکند که موقعیت آن در جمله را مشخص میکند. این بردارها با استفاده از توابع سینوسی و کسینوسی ساخته میشوند:

PE(pos, 2i) = sin(pos / 10000^(2i/d))

جایی که pos موقعیت کلمه، i ابعاد بردار، و d بعد کل embedding است.

چرا از توابع سینوسی؟ چون این توابع خواص جالبی دارند:

- برای هر موقعیت، یک بردار یکتا تولید میکنند

- مدل میتواند به راحتی فاصله نسبی بین دو موقعیت را یاد بگیرد

- برای جملات بلندتر از آنچه در آموزش دیده، هم کار میکنند

در مدلهای جدیدتر، گاهی از Learned Positional Embeddings استفاده میشود که به جای فرمول ثابت، در حین آموزش یاد گرفته میشوند.

کاربردهای واقعی ترنسفورمر

پردازش زبان طبیعی

ترجمه ماشینی: ترنسفورمرها توانستهاند کیفیت ترجمه را به طور چشمگیری بهبود دهند. سرویسهای ترجمه مدرن مانند Google Translate از ترنسفورمرها استفاده میکنند و میتوانند نه تنها کلمهبهکلمه، بلکه معنی و بافت جمله را نیز منتقل کنند.

تولید متن خلاقانه: مدلهایی مانند GPT میتوانند داستان، شعر، مقاله و حتی کد برنامهنویسی تولید کنند. این مدلها با یادگیری از میلیاردها صفحه متن، توانستهاند الگوهای زبانی پیچیده را درک کنند.

خلاصهسازی خودکار: ترنسفورمرها میتوانند متون طولانی را بخوانند و خلاصهای مفید و منسجم از آنها تولید کنند. این کاربرد در تحلیل اخبار، پژوهش علمی و مدیریت اطلاعات بسیار مفید است.

پاسخ به سوالات: سیستمهای پرسش و پاسخ مدرن میتوانند یک سند بلند را بخوانند و به سوالات دقیق درباره آن پاسخ دهند. این قابلیت در موتورهای جستجو، دستیارهای شخصی و سیستمهای آموزشی کاربرد دارد.

تحلیل احساسات: ترنسفورمرها میتوانند احساسات نویسنده یک متن (مثبت، منفی، خنثی) را تشخیص دهند. این در تحلیل نظرات مشتریان، رصد شبکههای اجتماعی و تحقیقات بازار بسیار کاربردی است.

بینایی ماشین

Vision Transformer (ViT): در سال 2020، محققان نشان دادند که میتوان ترنسفورمر را مستقیماً بر روی تصاویر اعمال کرد. یک تصویر را به پچهای کوچک (مثلاً 16×16 پیکسل) تقسیم میکنند و هر پچ را مانند یک "کلمه" در جمله در نظر میگیرند. ViT توانست در دستهبندی تصاویر عملکردی برابر یا بهتر از شبکههای کانولوشنی (CNN) داشته باشد.

تشخیص و تقسیمبندی اشیاء: ترنسفورمرها میتوانند اشیاء مختلف در یک تصویر را شناسایی و مرز آنها را مشخص کنند. این در خودروهای خودران، تشخیص پزشکی و امنیت کاربرد دارد.

تولید تصویر از متن: مدلهایی مانند DALL-E از ترنسفورمر برای تولید تصاویر از توضیحات متنی استفاده میکنند. میتوانید بگویید "یک گربه فضانورد در حال نقاشی روی مریخ" و مدل تصویری مطابق با توضیح شما بسازد.

پردازش صوت

تشخیص گفتار: ترنسفورمرها در سیستمهای تشخیص گفتار مدرن مانند Whisper نقش کلیدی دارند. این سیستمها میتوانند گفتار را با دقت بالا به متن تبدیل کنند، حتی در حضور نویز یا لهجههای مختلف.

تولید گفتار: ترنسفورمرها میتوانند متن را به گفتار طبیعی و انسانی تبدیل کنند. سیستمهای مدرن میتوانند حتی لحن، احساس و تأکید صحیح را در گفتار قرار دهند.

ترجمه گفتار: ترکیب تشخیص گفتار، ترجمه و تولید گفتار برای ترجمه زنده مکالمات.

تحلیل سریهای زمانی

ترنسفورمرها در پیشبینی سریهای زمانی نیز کاربرد یافتهاند:

پیشبینی مالی: تحلیل روند قیمت سهام، ارزها و کالاها با استفاده از دادههای تاریخی.

پیشبینی تقاضا: پیشبینی تقاضای محصولات برای مدیریت موجودی و زنجیره تأمین.

پیشبینی آب و هوا: استفاده از دادههای تاریخی آب و هوا برای پیشبینی دقیقتر شرایط آینده.

تحلیل سلامت: رصد علائم حیاتی بیماران و پیشبینی روند بیماریها.

علوم زیستی و پزشکی

پیشبینی ساختار پروتئین: AlphaFold 2 با استفاده از ترنسفورمر توانست یکی از بزرگترین مسائل زیستشناسی را حل کند: پیشبینی ساختار سهبعدی پروتئینها از روی توالی آمینواسیدهایشان.

کشف دارو: ترنسفورمرها میتوانند مولکولهای دارویی جدید را طراحی کنند یا اثرات داروهای موجود بر بیماریهای مختلف را پیشبینی کنند.

تحلیل ژنومیک: درک توالیهای DNA و RNA و پیشبینی عملکرد ژنها.

تشخیص بیماری: تحلیل تصاویر پزشکی (رادیولوژی، پاتولوژی) برای کمک به تشخیص دقیقتر بیماریها.

مزایای کلیدی ترنسفورمر

پردازش موازی

- RNN باید 100 مرحله متوالی پردازش انجام دهد

- ترنسفورمر میتواند تمام 100 کلمه را همزمان پردازش کند

این باعث میشود:

- سرعت آموزش 10 تا 100 برابر شود

- بتوان از قدرت کامل GPU و TPU استفاده کرد

- مدلهای بسیار بزرگتر قابل آموزش باشند

مدیریت وابستگیهای بلندمدت

در RNN و LSTM، اطلاعات کلمه اول جمله پس از عبور از دهها کلمه، ضعیف میشد. اما در ترنسفورمر، هر کلمه میتواند مستقیماً به هر کلمه دیگری توجه کند، حتی اگر 1000 کلمه فاصله داشته باشند. این یعنی:

- درک بهتر جملات پیچیده

- حفظ زمینه در متون طولانی

- شناسایی ارتباطات دور

مقیاسپذیری

ترنسفورمرها خاصیت جالبی دارند: هرچه بزرگتر شوند، بهتر عمل میکنند. این پدیده به قانون مقیاسپذیری (Scaling Laws) معروف است:

- GPT-2 با 1.5 میلیارد پارامتر

- GPT-3 با 175 میلیارد پارامتر

- مدلهای جدید با تریلیونها پارامتر

با افزایش اندازه مدل، تعداد دادههای آموزشی و قدرت محاسباتی، عملکرد به طور پیشبینیپذیر بهبود مییابد.

انعطافپذیری معماری

ترنسفورمر یک معماری عمومی است که میتوان آن را برای وظایف مختلف تطبیق داد:

- تغییر تعداد لایهها

- تغییر تعداد سرهای توجه

- افزودن لایههای تخصصی

- ترکیب با معماریهای دیگر

این انعطاف باعث شده که ترنسفورمر در حوزههای بسیار متنوعی از متن گرفته تا تصویر، صوت و حتی بازی کاربرد داشته باشد.

یادگیری انتقالی (Transfer Learning)

یکی از قدرتمندترین ویژگیهای ترنسفورمر، توانایی یادگیری انتقالی است. این بدان معناست که:

- ابتدا یک مدل بزرگ بر روی حجم عظیمی از داده عمومی پیشآموزش داده میشود

- سپس همین مدل با مقدار کمی داده اختصاصی برای یک وظیفه خاص تنظیم دقیق میشود

به عنوان مثال، GPT-3 بر روی میلیاردها صفحه متن از اینترنت آموزش دیده. حالا شما میتوانید با فقط چند صد یا چند هزار نمونه، آن را برای یک وظیفه خاص (مثلاً تحلیل نظرات مشتریان شرکت خود) تنظیم کنید. این در حالی است که اگر بخواهید از صفر یک مدل بسازید، به میلیونها نمونه نیاز دارید.

چالشهای ترنسفورمر و راهحلها

پیچیدگی محاسباتی درجه دوم

بزرگترین چالش ترنسفورمرهای سنتی، پیچیدگی محاسباتی O(n²) در مکانیزم توجه است. این بدان معناست که اگر طول جمله دو برابر شود، زمان محاسبه چهار برابر میشود.

برای جمله 1000 کلمهای، مدل باید 1,000,000 محاسبه توجه انجام دهد. برای جمله 10,000 کلمهای، این عدد به 100,000,000 میرسد که عملاً غیرممکن است.

راهحلها:

توجه اسپارس (Sparse Attention): به جای اینکه هر کلمه به تمام کلمات دیگر توجه کند، فقط به زیرمجموعهای توجه میکند. مثلاً:

- Sliding Window: هر کلمه فقط به 256 کلمه قبل و بعد خود توجه میکند

- Global Tokens: چند توکن خاص که به همه چیز دسترسی دارند

- Random Attention: توجه تصادفی برای حفظ جریان اطلاعات

FlashAttention: این الگوریتم با مدیریت هوشمند حافظه GPU، سرعت محاسبه توجه را 2-4 برابر افزایش میدهد بدون تغییر در نتیجه.

Linear Transformers: معماریهایی که پیچیدگی را از O(n²) به O(n) کاهش میدهند. مثلاً:

- Linformer: استفاده از پروجکشن برای کاهش بعد

- Performer: استفاده از تقریب هستهای

- RWKV: ترکیب مزایای RNN و Transformer

Mixture of Depths (MoD): در هر لایه، فقط برخی از توکنها پردازش کامل میشوند و بقیه از مسیر میانبر عبور میکنند. این کاهش 50% در محاسبات بدون افت کیفیت ایجاد میکند.

مصرف بالای حافظه

مدلهای ترنسفورمر بزرگ نیاز به حافظه زیادی دارند:

- GPT-3 (175B پارامتر): حدود 350 گیگابایت برای ذخیره وزنها

- در حین استنتاج: نیاز به ذخیره KV Cache برای تمام توکنهای قبلی

راهحلها:

کوانتیزاسیون (Quantization): کاهش دقت اعداد از 32-bit به 8-bit یا حتی 4-bit. این میتواند حافظه مورد نیاز را 4 تا 8 برابر کاهش دهد با افت کیفیت بسیار کم.

Grouped-Query Attention (GQA): به جای اینکه برای هر سر توجه یک کلید و مقدار جداگانه داشته باشیم، چند سر از یک KV مشترک استفاده میکنند. این حافظه KV Cache را 8 برابر کاهش میدهد.

مدلهای زبانی کوچک (SLM): مدلهایی با 1-7 میلیارد پارامتر که برای دستگاههای شخصی بهینه شدهاند و میتوانند روی لپتاپ یا موبایل اجرا شوند.

Knowledge Distillation: آموزش یک مدل کوچک (Student) با استفاده از خروجی یک مدل بزرگ (Teacher). مدل کوچک میتواند 10 برابر کوچکتر باشد اما 95% عملکرد مدل بزرگ را داشته باشد.

توهمزایی (Hallucination)

یکی از مشکلات جدی مدلهای ترنسفورمری، تولید اطلاعات نادرست با اطمینان بالا است. مدل ممکن است با کمال اطمینان بگوید که "پایتخت فرانسه برلین است" یا اطلاعات تاریخی کاملاً اشتباه ارائه دهد.

دلایل توهمزایی:

- یادگیری الگوهای آماری به جای واقعیتهای دنیای واقعی

- فشار برای تولید پاسخ حتی در مواقع عدم اطمینان

- تداخل و تضاد در دادههای آموزشی

- تمایل به تکمیل الگوها حتی با اطلاعات ناکافی

راهحلها:

Retrieval-Augmented Generation (RAG): قبل از تولید پاسخ، مدل ابتدا از پایگاه دادههای معتبر اطلاعات مرتبط را جستجو میکند و سپس بر اساس آن پاسخ میدهد. این روش دقت را به طور چشمگیری افزایش میدهد.

Chain of Thought (CoT): مدل را ملزم کنید که گامبهگام استدلال کند. وقتی مدل مجبور است فرآیند فکری خود را توضیح دهد، احتمال خطا کاهش مییابد.

آموزش با بازخورد انسانی (RLHF): استفاده از نظرات انسانی برای آموزش مدل تا پاسخهای دقیقتر و مفیدتر تولید کند.

Confidence Scoring: اضافه کردن قابلیت برای اینکه مدل بگوید "نمیدانم" یا میزان اطمینان خود را به پاسخ اعلام کند.

تعصب و انصاف

ترنسفورمرها بر روی دادههای اینترنت آموزش میبینند که خود حاوی تعصبات انسانی هستند:

- تعصبات جنسیتی (مثلاً پرستار = زن، مهندس = مرد)

- تعصبات نژادی و فرهنگی

- تعصبات اجتماعی-اقتصادی

- تعصبات زبانی (تمرکز بیش از حد بر زبان انگلیسی)

راهحلها:

- تنوع بیشتر در دادههای آموزشی

- فیلتر و بررسی دقیق دادهها قبل از آموزش

- تستهای منظم برای شناسایی تعصبات

- استفاده از تکنیکهای De-biasing در حین آموزش

هزینه محاسباتی بالا

آموزش مدلهای ترنسفورمر بزرگ بسیار پرهزینه است:

- GPT-3: تخمین 4.6 میلیون دلار برای یک بار آموزش

- مصرف انرژی معادل چندین خانه در یک سال

- نیاز به هزاران GPU برای ماهها

راهحلها:

- Mixture of Experts (MoE): به جای فعال کردن تمام پارامترها، فقط بخشی از شبکه برای هر ورودی فعال میشود. مدلی با 1.7 تریلیون پارامتر اما هزینه محاسباتی مدل 12 میلیارد پارامتری.

- Progressive Training: شروع با مدل کوچک و تدریجاً بزرگ کردن آن به جای شروع مستقیم با مدل بزرگ.

- Low-Rank Adaptation (LoRA): به جای تنظیم دقیق تمام پارامترها، فقط ماتریسهای کوچکی آموزش داده میشوند. این هزینه تنظیم دقیق را 100 برابر کاهش میدهد.

- مدلهای متنباز: استفاده مجدد از مدلهای پیشآموزش شده به جای آموزش از صفر.

تحولات اخیر در ترنسفورمرها

مدلهای هیبریدی

محققان دریافتهاند که ترکیب ترنسفورمر با معماریهای دیگر میتواند نتایج بهتری بدهد:

Mamba: معماری جدیدی بر پایه مدلهای فضای حالت (State Space Models) که پیچیدگی خطی دارد اما عملکرد ترنسفورمر را حفظ میکند. Mamba میتواند توالیهای میلیونی را پردازش کند.

Jamba: ترکیب لایههای Transformer و Mamba در یک مدل واحد. بهترین هر دو دنیا: توانایی مدلسازی پیچیده ترنسفورمر + کارایی Mamba.

RWKV: ترکیب ویژگیهای RNN (پیچیدگی خطی) با قدرت ترنسفورمر. میتواند مانند RNN استنتاج کند (سریع) اما مانند ترنسفورمر آموزش ببیند (موازی).

RetNet (Retentive Networks): جایگزینی مکانیزم توجه با مکانیزم "نگهداری" (Retention) که هم آموزش موازی دارد هم استنتاج سریع.

مدلهای چندوجهی (Multimodal)

نسل جدید ترنسفورمرها میتوانند چند نوع داده را همزمان پردازش کنند:

Gemini: مدل گوگل که به طور بومی متن، تصویر، صوت و ویدیو را درک میکند. میتوانید یک تصویر نشان دهید و دربارهاش سوال بپرسید یا یک ویدیو بدهید و خلاصهای از آن بخواهید.

GPT-4 Vision: توانایی درک تصاویر و توضیح آنها، پاسخ به سوالات بصری و حتی خواندن متن از تصاویر.

CLIP: مدل OpenAI که میتواند ارتباط میان تصاویر و متون را درک کند. پایه بسیاری از مدلهای تولید تصویر است.

این مدلها با یادگیری نمایشهای مشترک برای انواع مختلف داده، میتوانند وظایف پیچیدهتری انجام دهند که نیاز به درک چند حس است.

مدلهای استدلالی (Reasoning Models)

نسل جدیدی از مدلهای ترنسفورمری که بر روی استدلال عمیق تمرکز دارند:

o1 و o3-mini: مدلهای OpenAI که قبل از دادن پاسخ، زمان زیادی صرف "فکر کردن" میکنند. آنها میتوانند مسائل پیچیده ریاضی، برنامهنویسی و استدلال منطقی را حل کنند.

o4-mini: نسخه کوچکتر و سریعتر برای استدلال کارآمد.

این مدلها با استفاده از تکنیک زنجیره فکر و تقویت یادگیری (Reinforcement Learning)، یاد گرفتهاند که مسائل را مرحلهبهمرحله حل کنند و پاسخهای خود را بررسی کنند.

ترنسفورمرهای کارآمد برای Edge

Edge AI: حرکت به سمت اجرای مدلها بر روی دستگاههای شخصی به جای سرورهای ابری. مزایا:

- حفظ حریم خصوصی (دادهها دستگاه را ترک نمیکنند)

- کاهش تأخیر (بدون نیاز به ارتباط با سرور)

- کاهش هزینههای ابری

- کارکرد آفلاین

مدلهایی مانند Phi-3، Gemma و Llama 3.2 برای اجرا بر روی گوشیهای هوشمند و لپتاپها بهینه شدهاند.

ترنسفورمرهای تخصصی

مدلهای کد: مدلهایی مانند Codex، Code Llama و DeepSeek Coder که مخصوص درک و تولید کد برنامهنویسی هستند. آنها میتوانند:

- کد تولید کنند از توضیح طبیعی

- باگها را پیدا کنند

- کد را توضیح دهند

- کد را بهینه کنند

مدلهای علمی: مدلهایی که بر روی مقالات علمی، دادههای آزمایشگاهی و دانش تخصصی آموزش دیدهاند برای کمک به پژوهش علمی.

مدلهای قانونی و پزشکی: مدلهایی با دانش تخصصی در حوزههای خاص که میتوانند به متخصصان کمک کنند.

آینده ترنسفورمرها

مسیر به سمت AGI

بسیاری از محققان معتقدند که ترنسفورمرهای مقیاسشده، یکی از مسیرهای اصلی به سمت هوش مصنوعی عمومی (AGI) هستند. AGI به معنای سیستمی است که میتواند هر کار ذهنی انسان را انجام دهد.

چالشهای باقیمانده:

- استدلال علّی: درک روابط علت و معلول، نه فقط همبستگیها

- یادگیری چند-مرحلهای: حل مسائلی که نیاز به برنامهریزی بلندمدت دارند

- تعمیم واقعی: انتقال دانش به موقعیتهای کاملاً جدید

- فهم دنیای فیزیکی: درک قوانین فیزیک و تعامل با دنیای واقعی

مدلهای جهان (World Models)

یک روند مهم، توسعه مدلهای جهان است - مدلهایی که سعی میکنند شبیهسازی ذهنی از دنیا داشته باشند:

- درک فیزیک (اگر چیزی را رها کنم، میافتد)

- درک روابط اجتماعی (اگر به کسی توهین کنم، ناراحت میشود)

- پیشبینی آینده (اگر این کار را بکنم، چه اتفاقی میافتد؟)

این مدلها میتوانند به AGI نزدیکتر شوند چون دنیا را "درک" میکنند، نه فقط الگوهای آماری را یاد میگیرند.

یادگیری مداوم

مدلهای فعلی پس از آموزش ثابت هستند. مدلهای آینده باید بتوانند:

- از تعاملات با کاربران یاد بگیرند

- دانش جدید را بدون فراموشی دانش قدیم یاد بگیرند

- خود را بهینه کنند

ترنسفورمرهای نوروموفریک

محاسبات نوروموفیک: طراحی چیپهای اختصاصی که رفتار نورونهای مغز را تقلید میکنند. این چیپها میتوانند:

- مصرف انرژی را 1000 برابر کاهش دهند

- سرعت استنتاج را افزایش دهند

- اجرا بر روی دستگاههای IoT و edge را ممکن کنند

ترکیب با تکنولوژیهای دیگر

ترنسفورمر + بلاکچین: استفاده از بلاکچین برای اعتباربخشی به خروجیهای AI و مدیریت حقوق مالکیت دادهها.

ترنسفورمر + محاسبات کوانتومی: استفاده از قدرت کامپیوترهای کوانتومی برای آموزش سریعتر و حل مسائل بهینهسازی پیچیده.

ترنسفورمر + رباتیک: استفاده از ترنسفورمرها برای کنترل هوشمند رباتها و تعامل با دنیای فیزیکی.

ابزارها و منابع برای کار با ترنسفورمر

فریمورکهای یادگیری عمیق

PyTorch: محبوبترین فریمورک برای پژوهش و توسعه مدلهای ترنسفورمر. انعطافپذیر، آسان برای دیباگ و با جامعه بزرگ.

TensorFlow: فریمورک قدرتمند گوگل با ابزارهای عالی برای تولید و deployment. TensorFlow Lite برای دستگاههای موبایل.

Keras: API سطح بالا که کار با مدلهای عمیق را ساده میکند. اکنون بخشی از TensorFlow است.

JAX: فریمورک جدید برای محاسبات عددی با سرعت بالا و قابلیت مشتقگیری خودکار.

کتابخانههای تخصصی ترنسفورمر

Hugging Face Transformers: قدرتمندترین و کاملترین کتابخانه برای کار با ترنسفورمرها. دسترسی به هزاران مدل پیشآموزش شده، ابزارهای آموزش و استنتاج آسان.

Sentence Transformers: تخصصی برای تولید embeddingهای جمله و کاربردهای جستجوی معنایی.

Fairseq: کتابخانه Meta برای تحقیقات NLP و ترجمه ماشینی.

T5X: پیادهسازی کارآمد مدل T5 گوگل.

محیطهای آموزش

Google Colab: محیط رایگان Jupyter Notebook با دسترسی به GPU. عالی برای آزمایش و یادگیری.

Kaggle Notebooks: مشابه Colab با مجموعه دادههای آماده و رقابتهای ML.

Paperspace Gradient: محیط ابری برای آموزش مدلهای بزرگ با GPUهای قوی.

AWS SageMaker، Google Vertex AI، Azure ML: پلتفرمهای سازمانی برای آموزش و deployment مدلهای بزرگ.

مجموعه دادهها

Common Crawl: میلیاردها صفحه وب برای پیشآموزش مدلهای زبانی.

The Pile: مجموعه داده متنوع 800 گیگابایتی برای آموزش مدلهای زبانی.

ImageNet: استاندارد طلایی برای دستهبندی تصاویر.

GLUE و SuperGLUE: بنچمارکهای استاندارد برای ارزیابی مدلهای NLP.

ملاحظات اخلاقی و اجتماعی

حریم خصوصی

مدلهای ترنسفورمر بزرگ بر روی دادههای عمومی اینترنت آموزش میبینند که ممکن است حاوی اطلاعات شخصی باشند. این چالشهایی ایجاد میکند:

- مدل ممکن است اطلاعات خصوصی را به خاطر بسپارد و بازتولید کند

- امکان استخراج اطلاعات از مدلهای آموزشدیده

- تضاد بین دادههای مورد نیاز برای آموزش و حریم خصوصی افراد

راهحلها شامل یادگیری فدرال، حذف اطلاعات حساس از دادههای آموزشی و محدود کردن توانایی مدل در به خاطر سپردن اطلاعات خاص است.

تأثیر زیستمحیطی

آموزش مدلهای بزرگ مصرف انرژی قابل توجهی دارد:

- آموزش GPT-3 معادل 552 تن دیاکسید کربن تولید کرده (معادل 120 خودرو در یک سال)

- مراکز داده بزرگ مصرفکننده عمده آب و برق هستند

راهحلها:

- استفاده از انرژیهای تجدیدپذیر

- بهینهسازی الگوریتمها برای کاهش محاسبات

- استفاده مجدد از مدلهای پیشآموزش شده

- توسعه مدلهای کارآمدتر

تأثیر بر اشتغال

ترنسفورمرها میتوانند بسیاری از وظایف را خودکار کنند:

- ترجمه، نویسندگی، برنامهنویسی پایه

- پشتیبانی مشتری، تحلیل داده

- تولید محتوا، طراحی گرافیک

این تغییرات چالشها و فرصتهایی ایجاد میکنند:

- نیاز به بازآموزی نیروی کار

- ایجاد مشاغل جدید در حوزه AI

- تغییر در ماهیت کار انسانی

استفاده مخرب

ترنسفورمرها میتوانند برای اهداف مخرب استفاده شوند:

- تولید اخبار جعلی و دیساینفورمیشن

- فیشینگ و کلاهبرداریهای پیچیده

- تولید محتوای مضر یا غیرقانونی

- دستکاری افکار عمومی

شفافیت و تفسیرپذیری

مدلهای ترنسفورمر بزرگ مانند "جعبه سیاه" هستند - میدانیم خروجی چیست اما نمیدانیم چرا این پاسخ را داده است. این در برخی کاربردها (مثلاً تشخیص پزشکی یا تصمیمات قانونی) مشکلساز است.

تلاشها برای بهبود تفسیرپذیری:

- تجسم الگوهای توجه برای دیدن اینکه مدل به چه بخشهایی از ورودی توجه کرده

- تحلیل لایههای مختلف برای درک نوع اطلاعاتی که هر لایه یاد گرفته

- توسعه روشهای هوش مصنوعی قابل تفسیر (XAI)

دسترسی و شکاف دیجیتال

مدلهای ترنسفورمر پیشرفته به منابع عظیمی نیاز دارند که فقط شرکتهای بزرگ فناوری دسترسی به آن دارند. این شکافهایی ایجاد میکند:

- محققان دانشگاهی و کشورهای در حال توسعه دسترسی محدود دارند

- تمرکز قدرت در دست تعداد کمی شرکت

- عدم تنوع در توسعه فناوری

راهحلها شامل توسعه مدلهای متنباز، اشتراکگذاری منابع محاسباتی و سرمایهگذاری دولتی در زیرساختهای تحقیقاتی است.

کاربردهای صنعتی و تجاری

بخش مالی

تحلیل مالی و پیشبینی: ترنسفورمرها میتوانند گزارشهای مالی، اخبار اقتصادی و دادههای بازار را تحلیل کنند و روندهای آینده را پیشبینی کنند.

معاملات الگوریتمی: استفاده از ترنسفورمرها برای تحلیل احساسات بازار، تشخیص الگوها و تصمیمگیری خودکار در معاملات.

تشخیص تقلب: شناسایی الگوهای مشکوک در تراکنشها با دقت بالا.

ارزیابی ریسک اعتباری: تحلیل دادههای مشتریان برای پیشبینی احتمال بازپرداخت وام.

بخش سلامت

تشخیص و درمان: کمک به پزشکان در تشخیص بیماریها از روی علائم، تصاویر پزشکی و تاریخچه بیمار.

کشف دارو: تسریع فرآیند توسعه داروهای جدید با پیشبینی اثرات مولکولهای مختلف.

پزشکی شخصیشده: تجزیه و تحلیل ژنتیک و سابقه پزشکی برای ارائه درمانهای سفارشی.

مراقبت از راه دور: چتباتهای پزشکی برای مشاوره اولیه و پیگیری بیماران.

آموزش

آموزش شخصیشده: سیستمهایی که با درک سطح دانش و سبک یادگیری هر دانشجو، محتوای مناسب ارائه میدهند.

معلم مجازی: پاسخ به سوالات دانشجویان، توضیح مفاهیم پیچیده و ارائه بازخورد فوری.

تولید محتوای آموزشی: ایجاد تمرینها، آزمونها و مطالب آموزشی متناسب با برنامه درسی.

ترجمه و دسترسی: ترجمه خودکار محتوای آموزشی به زبانهای مختلف برای دسترسی جهانی.

بازاریابی و فروش

تولید محتوا: نوشتن توضیحات محصولات، پستهای شبکههای اجتماعی، ایمیلهای بازاریابی و مقالات وبلاگ.

سئو هوشمند: بهینهسازی محتوا برای موتورهای جستجو با تحلیل کلمات کلیدی و رقبا.

شخصیسازی: ارائه پیشنهادات و محتوای سفارشی به هر کاربر بر اساس رفتار و علایق او.

چتباتهای فروش: پاسخگویی خودکار به سوالات مشتریان و راهنمایی در فرآیند خرید.

خدمات مشتری

چتباتهای پیشرفته: پاسخگویی به سوالات رایج، حل مشکلات ساده و هدایت به منابع مناسب.

تحلیل احساسات: شناسایی مشتریان ناراضی و اولویتبندی درخواستها بر اساس فوریت.

پشتیبانی چندزبانه: ارائه خدمات به مشتریان در زبان مادریشان با ترجمه خودکار.

خلاصهسازی تماسها: تولید خودکار خلاصه گفتگوها برای پیگیری بهتر.

رسانه و سرگرمی

تولید زیرنویس: ایجاد خودکار زیرنویس برای ویدیوها و فیلمها.

توصیه محتوا: پیشنهاد فیلم، موسیقی یا مقاله بر اساس علایق کاربر.

تولید موسیقی و صدا: ایجاد موسیقی، جلوههای صوتی و صداگذاری.

نوشتن سناریو: کمک به فیلمنامهنویسان در ایدهپردازی و توسعه داستان.

حقوق و قضا

تحقیق حقوقی: جستجو و تحلیل پروندههای قانونی، قوانین و مقررات مرتبط.

پیشنویس قراردادها: تولید خودکار پیشنویس قراردادهای استاندارد.

پیشبینی نتایج: تحلیل پروندههای مشابه برای پیشبینی احتمال موفقیت در دادگاه.

خلاصهسازی اسناد: خلاصه کردن اسناد حقوقی طولانی برای بررسی سریعتر.

منابع انسانی

استخدام هوشمند: غربالگری رزومهها، تطبیق نامزدها با موقعیتهای شغلی و انجام مصاحبههای اولیه.

تحلیل فرهنگ سازمانی: بررسی نظرسنجیهای کارکنان و شناسایی مشکلات.

برنامههای آموزشی: ایجاد محتوای آموزشی سفارشی برای کارکنان.

ارزیابی عملکرد: تحلیل دادهها و ارائه بازخورد سازنده.

نکات عملی برای شروع کار با ترنسفورمر

برای مبتدیان

1. شروع با مدلهای پیشآموزش شده: به جای آموزش از صفر، از مدلهای آماده در Hugging Face استفاده کنید. مدلهایی مانند BERT، GPT-2 یا T5 برای یادگیری عالی هستند.

2. استفاده از Google Colab: برای تمرین و آزمایش، از Google Colab استفاده کنید که GPU رایگان ارائه میدهد.

3. یادگیری مفاهیم پایه: قبل از پیادهسازی، مفاهیم اساسی مانند توجه، embedding و tokenization را به خوبی درک کنید.

4. شروع با وظایف ساده: ابتدا کارهای ساده مانند دستهبندی متن یا تحلیل احساسات را امتحان کنید.

برای حرفهایها

1. تنظیم دقیق موثر: از تکنیکهای مانند LoRA برای تنظیم دقیق کارآمد استفاده کنید.

2. بهینهسازی برای تولید: از تکنیکهایی مانند کوانتیزاسیون، pruning و knowledge distillation برای کاهش اندازه و افزایش سرعت استفاده کنید.

3. مدیریت توالیهای طولانی: برای کار با متون بلند، از تکنیکهای توجه اسپارس یا RAG استفاده کنید.

4. مانیتورینگ و ارزیابی: سیستمهای رصد کیفیت برای شناسایی توهمزایی و مشکلات دیگر بسازید.

منابع یادگیری

دورههای آنلاین:

- CS224N (Stanford): پردازش زبان طبیعی با یادگیری عمیق

- Fast.ai: دوره عملی یادگیری عمیق

- Hugging Face Course: آموزش کار با ترنسفورمرها

کتابها:

- "Natural Language Processing with Transformers" از Hugging Face

- "Attention Is All You Need" مقاله اصلی ترنسفورمر

- "Deep Learning" از Ian Goodfellow

جوامع آنلاین:

- Hugging Face Forums

- Reddit r/MachineLearning

- Discord و Slack کانالهای AI

نتیجهگیری

مدل ترنسفورمر در کمتر از یک دهه، از یک ایده تحقیقاتی به پایه اصلی هوش مصنوعی مدرن تبدیل شده است. این معماری با استفاده از مکانیزم توجه، توانسته محدودیتهای اساسی مدلهای قبلی را برطرف کند و امکان توسعه سیستمهای هوشمندی را فراهم آورد که قبلاً غیرممکن به نظر میرسیدند.

از پردازش زبان طبیعی و بینایی ماشین گرفته تا کشف دارو و پیشبینی مالی، ترنسفورمرها کاربردهای متنوعی یافتهاند که زندگی روزمره، صنعت و علم را متحول کردهاند. مدلهای زبانی بزرگی مانند GPT، Claude و Gemini که امروزه با آنها تعامل داریم، همگی بر پایه این معماری ساخته شدهاند.

با این حال، ترنسفورمرها با چالشهای مهمی نیز مواجه هستند: پیچیدگی محاسباتی بالا، مصرف انرژی قابل توجه، توهمزایی، تعصبات و مسائل اخلاقی. تحقیقات جاری بر روی حل این مشکلات تمرکز دارد - از توسعه معماریهای کارآمدتر مانند Mamba و RWKV گرفته تا تکنیکهای RAG و زنجیره فکر برای افزایش دقت.

آینده ترنسفورمرها روشن به نظر میرسد. با پیشرفتهای مداوم در معماری، الگوریتمهای آموزش و سختافزار، انتظار میرود این مدلها قدرتمندتر، کارآمدتر و دسترسپذیرتر شوند. مسیر به سمت هوش مصنوعی عمومی (AGI)، توسعه مدلهای جهان و ترکیب با تکنولوژیهای نوظهور مانند محاسبات کوانتومی و محاسبات نوروموفیک، همگی نوید آیندهای هیجانانگیز را میدهند.

در نهایت، ترنسفورمر نه تنها یک معماری فنی، بلکه نمایانگر تغییر پارادایم در نحوه طراحی و ساخت سیستمهای هوشمند است - حرکت از قوانین دستی و ویژگیهای طراحیشده به سمت یادگیری الگوها از دادهها و استفاده از توجه برای درک روابط پیچیده. این تغییر پارادایم، تأثیری عمیق و ماندگار بر آینده هوش مصنوعی و آینده کار و زندگی بشر خواهد داشت.

✨

با دیپفا، دنیای هوش مصنوعی در دستان شماست!!

🚀به دیپفا خوش آمدید، جایی که نوآوری و هوش مصنوعی با هم ترکیب میشوند تا دنیای خلاقیت و بهرهوری را دگرگون کنند!

- 🔥 مدلهای زبانی پیشرفته: از Dalle، Stable Diffusion، Gemini 2.5 Pro، Claude 4.5، GPT-5 و دیگر مدلهای قدرتمند بهرهبرداری کنید و محتوای بینظیری خلق کنید که همگان را مجذوب خود کند.

- 🔥 تبدیل متن به صدا و بالتصویر: با فناوریهای پیشرفته ما، به سادگی متنهای خود را به صدا تبدیل کنید و یا از صدا، متنهای دقیق و حرفهای بسازید.

- 🔥 تولید و ویرایش محتوا: از ابزارهای ما برای خلق متنها، تصاویر و ویدئوهای خیرهکننده استفاده کنید و محتوایی بسازید که در یادها بماند.

- 🔥 تحلیل داده و راهکارهای سازمانی: با پلتفرم API ما، تحلیل دادههای پیچیده را به سادگی انجام دهید و بهینهسازیهای کلیدی برای کسبوکار خود را به عمل آورید.

✨ با دیپفا، به دنیای جدیدی از امکانات وارد شوید! برای کاوش در خدمات پیشرفته و ابزارهای ما، به وبسایت ما مراجعه کنید و یک قدم به جلو بردارید:

کاوش در خدمات مادیپفا همراه شماست تا با ابزارهای هوش مصنوعی فوقالعاده، خلاقیت خود را به اوج برسانید و بهرهوری را به سطحی جدید برسانید. اکنون وقت آن است که آینده را با هم بسازیم!