وبلاگ / انتقال دانش در یادگیری عمیق: فشردهسازی هوشمند مدلهای عصبی

انتقال دانش در یادگیری عمیق: فشردهسازی هوشمند مدلهای عصبی

مقدمه

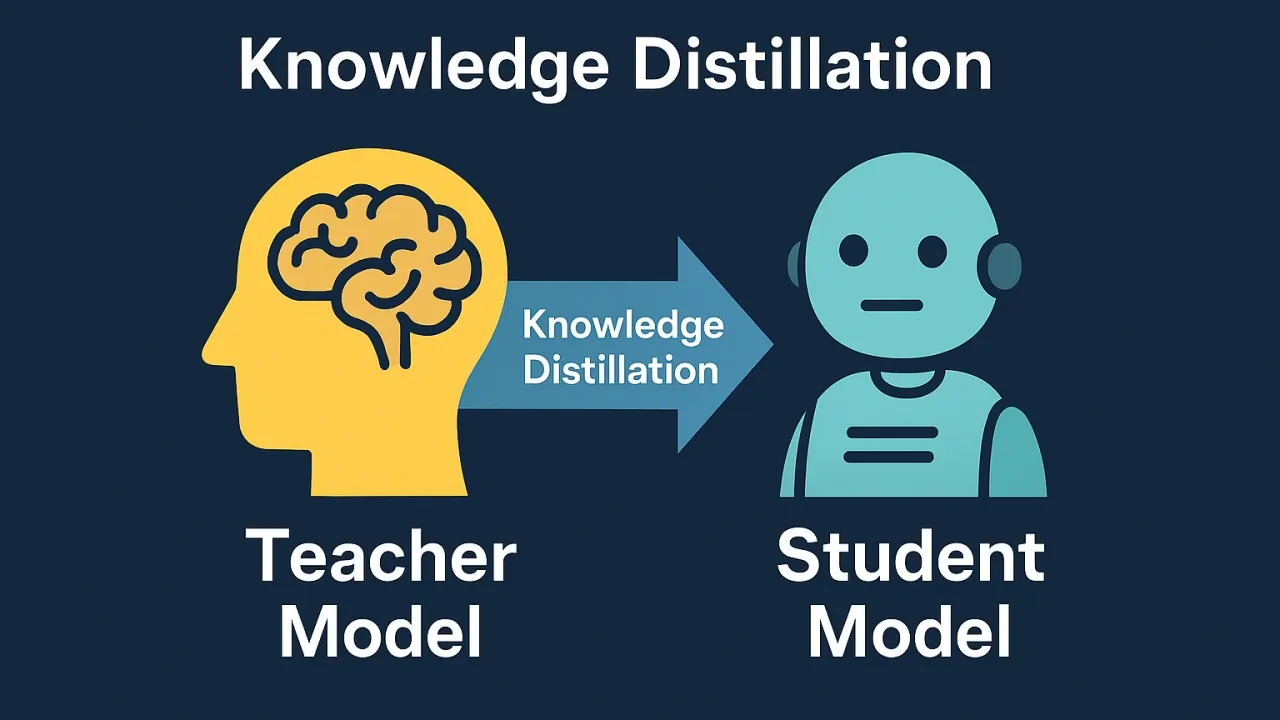

یک استاد باتجربه که سالها در دانشگاه تدریس کرده، وقتی بخواهد تمام دانش و تجربه خود را در مدت کوتاهی به یک دانشجوی تازهکار منتقل کند، در واقع همان کاری را انجام میدهد که Knowledge Distillation یا انتقال دانش در یادگیری عمیق انجام میدهد. این تکنیک امکان میدهد دانش یک مدل بزرگ و پیچیده به مدلی کوچکتر و سریعتر منتقل شود، بدون اینکه کیفیت قابلتوجهی کاهش یابد.

در دنیای امروز که هوش مصنوعی به سرعت در حال گسترش است، نیاز به مدلهایی که هم دقیق باشند و هم سریع عمل کنند، بیش از پیش احساس میشود. مدلهای بزرگ مانند GPT-4 یا Claude Sonnet 4 عملکرد فوقالعادهای دارند، اما حجم و پیچیدگی آنها باعث میشود استفاده از آنها در دستگاههای موبایل یا سیستمهای با منابع محدود چالشبرانگیز باشد. انتقال دانش راهحلی هوشمندانه برای این مشکل است.

انتقال دانش چیست؟

Knowledge Distillation یک تکنیک یادگیری ماشین است که در آن یک مدل کوچک (که به آن Student Model یا مدل دانشآموز میگوییم) از یک مدل بزرگ و آموزشدیده (که به آن Teacher Model یا مدل معلم میگوییم) یاد میگیرد. این فرآیند شبیه به رابطه استاد و شاگرد در دنیای واقعی است، با این تفاوت که در اینجا، انتقال دانش از طریق الگوریتمهای ریاضی و احتمالاتی انجام میشود.

ایده اصلی این است که به جای آموزش مستقیم مدل کوچک روی دادههای اولیه، آن را با استفاده از خروجیهای نرم (Soft Targets) مدل بزرگ آموزش دهیم. این خروجیهای نرم حاوی اطلاعات بیشتری نسبت به برچسبهای سخت (Hard Labels) هستند و به مدل دانشآموز کمک میکنند تا روابط پیچیدهتر بین کلاسها را درک کند.

مثال ملموس

فرض کنید شما یک شبکه عصبی بزرگ دارید که تصاویر حیوانات را با دقت 95 درصد تشخیص میدهد. این مدل 500 میلیون پارامتر دارد و اجرای آن روی یک گوشی هوشمند عادی چندین ثانیه طول میکشد. با استفاده از انتقال دانش، میتوانید یک مدل 10 میلیون پارامتری بسازید که همان تصویر را در کسری از ثانیه با دقت 92 درصد تشخیص میدهد. این یعنی شما تنها 3 درصد از دقت را از دست دادهاید، اما سرعت اجرا 50 برابر شده و حجم مدل به یک بیستم کاهش یافته است!

چگونه انتقال دانش کار میکند؟

ساختار پایه

در یک سناریوی معمولی انتقال دانش، ما دو مدل داریم:

- مدل معلم (Teacher Model): یک مدل یادگیری عمیق بزرگ و پیچیده که روی مجموعه داده اصلی آموزش دیده و عملکرد عالی دارد.

- مدل دانشآموز (Student Model): یک مدل کوچکتر با معماری سادهتر که قرار است دانش را از مدل معلم بیاموزد.

فرآیند آموزش

فرآیند انتقال دانش معمولاً در چند مرحله انجام میشود:

مرحله اول: مدل معلم روی دادههای آموزشی اصلی آموزش داده میشود تا به بهترین عملکرد ممکن برسد. این مدل معمولاً یک شبکه عصبی عمیق با میلیونها پارامتر است.

مرحله دوم: برای هر نمونه داده، مدل معلم یک بردار احتمالاتی تولید میکند که نشان میدهد هر کلاس چقدر محتمل است. این بردارها با استفاده از پارامتری به نام Temperature نرمتر میشوند.

مرحله سوم: مدل دانشآموز با استفاده از ترکیبی از دو تابع زیان آموزش داده میشود:

- زیان سخت (Hard Loss): اختلاف بین پیشبینی مدل دانشآموز و برچسبهای واقعی

- زیان نرم (Soft Loss): اختلاف بین پیشبینی مدل دانشآموز و خروجی نرمشده مدل معلم

نقش Temperature در انتقال دانش

Temperature یکی از مهمترین هایپرپارامترها در انتقال دانش است. این پارامتر توزیع احتمال خروجی را کنترل میکند. با افزایش Temperature، توزیع احتمال نرمتر و یکنواختتر میشود، که به مدل دانشآموز اجازه میدهد روابط بین کلاسهای مختلف را بهتر یاد بگیرد.

به عنوان مثال، فرض کنید مدل معلم برای تصویر یک سگ، احتمالات زیر را پیشبینی میکند:

- سگ: 90%

- گرگ: 8%

- روباه: 2%

این اطلاعات اضافی (اینکه گرگ شبیهتر از روباه است) در برچسب سخت (که فقط میگوید "سگ") موجود نیست. Temperature این اطلاعات ارزشمند را حفظ میکند.

انواع روشهای انتقال دانش

1. انتقال دانش مبتنی بر پاسخ (Response-Based)

این سادهترین و رایجترین نوع انتقال دانش است که در آن تنها خروجی نهایی مدل معلم برای آموزش مدل دانشآموز استفاده میشود. این روش برای مسائل دستهبندی بسیار مؤثر است و پیادهسازی آن نسبتاً ساده است.

2. انتقال دانش مبتنی بر ویژگی (Feature-Based)

در این روش، علاوه بر خروجی نهایی، از لایههای میانی مدل معلم نیز استفاده میشود. مدل دانشآموز سعی میکند نمایشهای ویژگی (Feature Representations) مشابهی با مدل معلم یاد بگیرد. این روش معمولاً در شبکههای عصبی کانولوشنی برای مسائل بینایی کامپیوتر استفاده میشود.

3. انتقال دانش مبتنی بر رابطه (Relation-Based)

این روش پیچیدهتر بوده و روی روابط بین نمونههای مختلف تمرکز دارد. به جای اینکه فقط خروجی برای هر نمونه را یاد بگیرد، مدل دانشآموز میآموزد که چگونه مدل معلم نمونههای مختلف را به هم مرتبط میکند.

4. انتقال دانش خودمحور (Self-Distillation)

در این روش جالب، یک مدل به عنوان معلم خودش عمل میکند! ابتدا مدل آموزش داده میشود، سپس از خروجیهای خودش برای آموزش مجدد و بهبود عملکرد استفاده میکند. این تکنیک میتواند به بهبود تعمیمپذیری مدل کمک کند.

مزایای شگفتانگیز انتقال دانش

کاهش چشمگیر حجم مدل

یکی از بزرگترین مزایای انتقال دانش، فشردهسازی مدل است. در دنیای واقعی، مدلهای زبانی بزرگ مانند GPT-4 ممکن است چندین صد گیگابایت حجم داشته باشند. با استفاده از انتقال دانش، میتوان مدلی با حجم چند صد مگابایت ساخت که عملکرد نزدیک به مدل اصلی داشته باشد.

مثال عملی: شرکت OpenAI با استفاده از تکنیکهای مشابه انتقال دانش، توانست نسخههای کوچکتری از GPT را مانند GPT-4-Mini تولید کند که 10 برابر کوچکتر و 5 برابر سریعتر هستند، اما همچنان عملکرد فوقالعادهای در اکثر وظایف دارند.

افزایش سرعت استنتاج

مدلهای کوچکتر به طور طبیعی سریعتر هستند. در کاربردهای real-time مانند تشخیص چهره یا پردازش زبان طبیعی در دستگاههای موبایل، سرعت بسیار حیاتی است. انتقال دانش به ما اجازه میدهد مدلهایی بسازیم که میتوانند در زمان واقعی و روی دستگاههای با منابع محدود اجرا شوند.

کاهش مصرف انرژی

مدلهای کوچکتر نیاز به قدرت پردازشی کمتری دارند، که به معنای مصرف انرژی کمتر است. این موضوع به خصوص در دستگاههای لبه (Edge Devices) و اینترنت اشیا بسیار اهمیت دارد، جایی که باتری محدود است.

بهبود تعمیمپذیری

جالب است بدانید که گاهی اوقات مدل دانشآموز حتی بهتر از برخی جنبههای مدل معلم عمل میکند! این به این دلیل است که فرآیند انتقال دانش مانند یک نوع Regularization عمل میکند و از بیشبرازش (Overfitting) جلوگیری میکند.

کاربردهای واقعی انتقال دانش

دستیارهای صوتی

دستیارهای صوتی مانند Siri، Alexa و Assistant های هوش مصنوعی از انتقال دانش بهره میبرند. آنها باید به سرعت و در همان لحظه به درخواستهای شما پاسخ دهند. مدلهای بزرگ برای این کار مناسب نیستند، اما مدلهای کوچکتری که از انتقال دانش استفاده کردهاند، میتوانند تشخیص گفتار را به سرعت و با دقت بالا انجام دهند.

خودروهای خودران

در صنعت خودرو، خودروهای خودران باید تصمیمات فوری بگیرند. آنها نمیتوانند منتظر بمانند تا یک مدل غولپیکر محاسبات را روی سرور انجام دهد. با استفاده از انتقال دانش، مدلهای کوچکی در خودرو نصب میشوند که میتوانند در زمان واقعی عابرین، خطوط خیابان، و سایر خودروها را تشخیص دهند.

تشخیص پزشکی

در پزشکی و تشخیص بیماری، مدلهای بزرگ روی میلیونها تصویر پزشکی آموزش داده میشوند. اما بیمارستانها و کلینیکها نمیتوانند همیشه به سرورهای قدرتمند دسترسی داشته باشند. مدلهای کوچکتری که از انتقال دانش استفاده کردهاند، میتوانند روی دستگاههای پزشکی معمولی اجرا شوند و به پزشکان در تشخیص سریعتر بیماریهایی مانند سرطان کمک کنند.

تلفنهای همراه

بسیاری از قابلیتهای هوش مصنوعی در گوشیهای هوشمند مانند فیلترهای دوربین، ترجمه فوری، یا پیشنهادات متنی، از مدلهایی استفاده میکنند که با انتقال دانش فشرده شدهاند. برای مثال، Google Translate میتواند متون را به صورت آفلاین ترجمه کند، چرا که از مدلهای کوچک و بهینهشده استفاده میکند.

امنیت سایبری

در امنیت سایبری، سیستمها باید به سرعت تهدیدات را شناسایی کنند. مدلهای بزرگی که روی میلیونها نمونه حمله آموزش دیدهاند، دانش خود را به مدلهای کوچکتری منتقل میکنند که میتوانند به صورت real-time ترافیک شبکه را تحلیل کنند.

چالشها و راهحلها

انتخاب معماری مناسب

یکی از چالشهای اصلی، انتخاب معماری مناسب برای مدل دانشآموز است. اگر مدل خیلی کوچک باشد، نمیتواند دانش کافی را جذب کند. اگر خیلی بزرگ باشد، مزیت انتقال دانش از بین میرود.

راهحل: استفاده از تکنیکهای Neural Architecture Search میتواند به یافتن بهترین معماری کمک کند. همچنین میتوان از معماریهای کارآمد مانند MobileNet یا EfficientNet استفاده کرد.

تنظیم Temperature

پیدا کردن مقدار بهینه Temperature یک هنر است. مقدار خیلی کم باعث میشود توزیع احتمال خیلی تیز باشد و اطلاعات کمی منتقل شود. مقدار خیلی زیاد باعث میشود توزیع خیلی یکنواخت شود و اطلاعات مفید از دست برود.

راهحل: معمولاً مقادیری بین 3 تا 10 برای Temperature خوب عمل میکنند، اما باید با آزمایش و خطا بهترین مقدار را پیدا کرد.

تعادل بین زیان سخت و نرم

تعیین وزن مناسب برای ترکیب زیان سخت و نرم چالشبرانگیز است. اگر وزن زیان نرم خیلی زیاد باشد، مدل دانشآموز ممکن است روی برچسبهای واقعی عملکرد ضعیفی داشته باشد.

راهحل: معمولاً از یک ضریب وزنی (معمولاً بین 0.5 تا 0.9) برای زیان نرم استفاده میشود و بقیه وزن به زیان سخت اختصاص مییابد.

مقایسه انتقال دانش با سایر تکنیکها

| تکنیک | مزایا | معایب | کاربرد اصلی |

|---|---|---|---|

| Knowledge Distillation | حفظ دقت بالا در مدل کوچک، انتقال دانش ضمنی | نیاز به مدل معلم آموزشدیده، زمانبر | فشردهسازی مدل برای استقرار |

| Pruning | کاهش مستقیم پارامترها، سادگی پیادهسازی | ممکن است دقت کاهش یابد، نیاز به Fine-tuning | حذف وزنهای غیرضروری |

| Quantization | کاهش حجم حافظه، سرعت اجرا بالا | کاهش دقت محاسبات، پیچیدگی پیادهسازی | تبدیل وزنها به دقت پایینتر |

| Transfer Learning | استفاده از دانش از پیش آموخته، سرعت آموزش بالا | محدود به دامنههای مرتبط، نیاز به Fine-tuning | استفاده از مدلهای پیشآموخته |

| LoRA | کاهش پارامترهای قابل آموزش، حافظه کم | نیاز به معماری خاص، محدودیت در برخی وظایف | Fine-tuning مدلهای بزرگ |

تکنیکهای پیشرفته انتقال دانش

Multi-Teacher Distillation

در این روش پیشرفته، به جای یک مدل معلم، از چندین مدل معلم استفاده میشود. هر کدام از مدلهای معلم ممکن است در جنبه خاصی از وظیفه تخصص داشته باشند، و مدل دانشآموز از همه آنها یاد میگیرد.

مثال کاربردی: در یک سیستم تشخیص بیماری، یک مدل معلم میتواند در تشخیص سرطان تخصص داشته باشد، مدل دیگر در بیماریهای قلبی، و مدل دانشآموز از هر دو یاد بگیرد تا یک سیستم جامع تشخیص پزشکی شود.

Cross-Modal Distillation

این تکنیک شگفتانگیز به انتقال دانش بین مدلهای با ورودیهای مختلف اشاره دارد. برای مثال، یک مدل که روی تصویر کار میکند میتواند دانش خود را به مدلی که روی متن کار میکند منتقل کند.

کاربرد واقعی: در سیستمهای چندحسی (Multimodal)، این تکنیک میتواند به ساخت دستیارهای هوشمندی کمک کند که هم تصویر و هم صدا را درک میکنند.

Progressive Distillation

در این روش، به جای انتقال مستقیم از یک مدل بزرگ به یک مدل خیلی کوچک، این کار به صورت تدریجی انجام میشود. ابتدا به یک مدل متوسط، سپس به مدل کوچک تر منتقل میشود.

Online Distillation

برخلاف روش معمولی که ابتدا مدل معلم کاملاً آموزش داده میشود، در Online Distillation هر دو مدل به صورت همزمان آموزش میبینند و از یکدیگر یاد میگیرند.

ارتباط با تکنولوژیهای نوین

انتقال دانش و مدلهای زبانی کوچک

با ظهور مدلهای زبانی کوچک (SLM)، انتقال دانش اهمیت بیشتری پیدا کرده است. شرکتهایی مانند Anthropic با Claude Haiku و Google با Gemini Flash از این تکنیک برای ساخت مدلهایی استفاده میکنند که هم سریع هستند و هم دقیق.

ترکیب با RAG

Retrieval-Augmented Generation (RAG) با انتقال دانش میتواند ترکیب قدرتمندی ایجاد کند. مدل کوچک میتواند دانش عمومی را از مدل بزرگ یاد بگیرد، و سپس از RAG برای دسترسی به اطلاعات بهروز استفاده کند.

Edge AI و انتقال دانش

در Edge AI، محدودیتهای سختافزاری بسیار مهم هستند. انتقال دانش به ما اجازه میدهد مدلهایی بسازیم که میتوانند روی دستگاههای IoT با حافظه و پردازنده محدود اجرا شوند.

یادگیری فدرال و انتقال دانش

یادگیری فدرال (Federated Learning) با انتقال دانش میتواند برای حفظ حریم خصوصی و در عین حال استفاده از دانش مدلهای بزرگ مفید باشد. مدل معلم بزرگ روی سرور مرکزی میماند و فقط دانش آن به مدلهای کوچک روی دستگاههای کاربران منتقل میشود.

پیادهسازی عملی انتقال دانش

استفاده از PyTorch

PyTorch یکی از محبوبترین فریمورکها برای پیادهسازی انتقال دانش است. در اینجا یک نمونه ساده از نحوه پیادهسازی را بررسی میکنیم:

python

import torch

استفاده از TensorFlow/Keras

TensorFlow و Keras نیز ابزارهای عالی برای انتقال دانش هستند. پیادهسازی با Keras بسیار ساده و بصری است.

آینده انتقال دانش

مدلهای خودبهبود

یکی از جالبترین روندها، ترکیب انتقال دانش با مدلهای خودبهبود است. این مدلها میتوانند به طور مداوم از تجربیات جدید یاد بگیرند و دانش خود را به نسخههای کوچکتر منتقل کنند.

انتقال دانش در AGI

با پیشرفت به سمت هوش مصنوعی عمومی (AGI)، انتقال دانش نقش کلیدی خواهد داشت. سیستمهای AGI باید بتوانند دانش خود را به سرعت و کارآمد به ماژولهای مختلف منتقل کنند.

انتقال دانش چندوظیفهای

آینده احتمالاً شاهد مدلهایی خواهیم بود که میتوانند دانش را برای چندین وظیفه به طور همزمان منتقل کنند. این میتواند به ساخت سیستمهای هوش مصنوعی چندمنظوره کمک کند.

انتقال دانش و محاسبات کوانتومی

ترکیب محاسبات کوانتومی با انتقال دانش میتواند به ما اجازه دهد که مدلهای بسیار پیچیدهتر را فشرده کنیم و دانش آنها را به مدلهای کلاسیک منتقل کنیم.

نکات کلیدی برای موفقیت در انتقال دانش

- انتخاب مدل معلم مناسب: مدل معلم باید در وظیفه مورد نظر عملکرد بسیار خوبی داشته باشد. یک مدل معلم ضعیف نمیتواند دانش ارزشمندی منتقل کند.

- تعیین معماری بهینه برای مدل دانشآموز: مدل دانشآموز باید به اندازه کافی ظرفیت داشته باشد تا دانش را جذب کند، اما نباید آنقدر بزرگ باشد که مزیت فشردهسازی از بین برود.

- تنظیم دقیق هایپرپارامترها: Temperature، نسبت زیان سخت و نرم، و نرخ یادگیری همه باید به دقت تنظیم شوند.

- استفاده از Data Augmentation: تقویت داده (Data Augmentation) میتواند به بهبود تعمیمپذیری مدل دانشآموز کمک کند.

- ارزیابی مداوم: عملکرد مدل دانشآموز باید در طول فرآیند آموزش به طور مداوم ارزیابی شود تا مطمئن شویم که دانش به درستی منتقل میشود.

نتیجهگیری

Knowledge Distillation یکی از قدرتمندترین و کاربردیترین تکنیکها در یادگیری ماشین مدرن است. این تکنیک به ما اجازه میدهد که از قدرت مدلهای بزرگ و پیچیده بهرهمند شویم، در حالی که مدلهای کوچک و کارآمدی برای استقرار در دنیای واقعی داریم.

با رشد روزافزون کاربردهای هوش مصنوعی در زندگی روزمره، از خانههای هوشمند گرفته تا تشخیص پزشکی و خودروهای خودران، نیاز به مدلهای سریع، کارآمد و دقیق بیش از پیش احساس میشود. انتقال دانش پلی است بین دنیای مدلهای قدرتمند تحقیقاتی و نیازهای عملی دنیای واقعی.

در آینده، انتظار میرود که تکنیکهای پیشرفتهتری از انتقال دانش توسعه یابد که بتوانند دانش را به شکلهای پیچیدهتر و با کارایی بیشتر منتقل کنند. ترکیب انتقال دانش با تکنولوژیهای نوظهور مانند محاسبات کوانتومی، یادگیری فدرال، و مدلهای چندوجهی میتواند انقلابی در نحوه استفاده ما از هوش مصنوعی ایجاد کند.

برای کسانی که میخواهند در این حوزه فعالیت کنند، یادگیری انتقال دانش و تکنیکهای مرتبط با آن مانند Fine-tuning، LoRA، و QLoRA ضروری است. این دانش میتواند به شما کمک کند تا راهحلهای کارآمد و مقیاسپذیر برای مسائل واقعی ایجاد کنید.

✨

با دیپفا، دنیای هوش مصنوعی در دستان شماست!!

🚀به دیپفا خوش آمدید، جایی که نوآوری و هوش مصنوعی با هم ترکیب میشوند تا دنیای خلاقیت و بهرهوری را دگرگون کنند!

- 🔥 مدلهای زبانی پیشرفته: از Dalle، Stable Diffusion، Gemini 2.5 Pro، Claude 4.5، GPT-5 و دیگر مدلهای قدرتمند بهرهبرداری کنید و محتوای بینظیری خلق کنید که همگان را مجذوب خود کند.

- 🔥 تبدیل متن به صدا و بالتصویر: با فناوریهای پیشرفته ما، به سادگی متنهای خود را به صدا تبدیل کنید و یا از صدا، متنهای دقیق و حرفهای بسازید.

- 🔥 تولید و ویرایش محتوا: از ابزارهای ما برای خلق متنها، تصاویر و ویدئوهای خیرهکننده استفاده کنید و محتوایی بسازید که در یادها بماند.

- 🔥 تحلیل داده و راهکارهای سازمانی: با پلتفرم API ما، تحلیل دادههای پیچیده را به سادگی انجام دهید و بهینهسازیهای کلیدی برای کسبوکار خود را به عمل آورید.

✨ با دیپفا، به دنیای جدیدی از امکانات وارد شوید! برای کاوش در خدمات پیشرفته و ابزارهای ما، به وبسایت ما مراجعه کنید و یک قدم به جلو بردارید:

کاوش در خدمات مادیپفا همراه شماست تا با ابزارهای هوش مصنوعی فوقالعاده، خلاقیت خود را به اوج برسانید و بهرهوری را به سطحی جدید برسانید. اکنون وقت آن است که آینده را با هم بسازیم!