وبلاگ / مدلهای Self-Rewarding: چگونه هوش مصنوعی خودش را بهبود میبخشد؟

مدلهای Self-Rewarding: چگونه هوش مصنوعی خودش را بهبود میبخشد؟

مقدمه

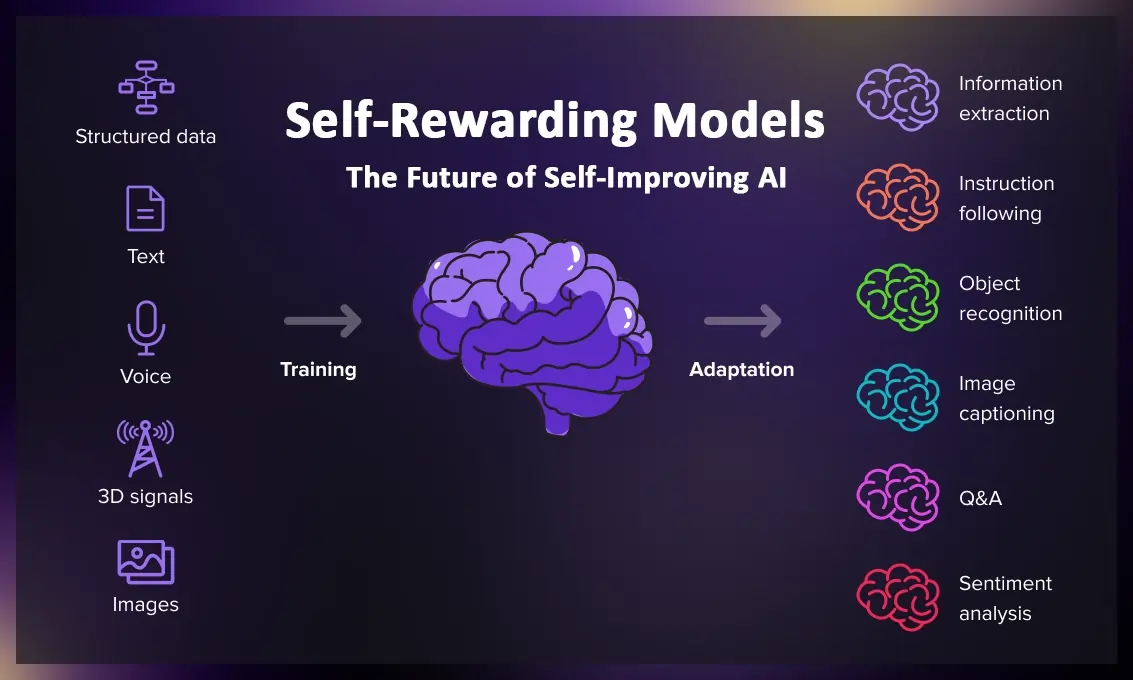

دانشآموزی را در نظر بگیرید که نه تنها مسائل ریاضی را حل میکند، بلکه میتواند کیفیت پاسخهای خود را ارزیابی کرده و بدون نیاز به معلم، خودش را بهبود دهد. در دنیای هوش مصنوعی، مدلهای Self-Rewarding دقیقاً چنین قابلیتی را ارائه میکنند.

مدلهای Self-Rewarding یک رویکرد انقلابی در آموزش مدلهای زبانی بزرگ هستند که در آن مدل بهجای اتکا به بازخورد انسانی یا مدلهای پاداش ثابت، خودش قاضی کار خود میشود. این مدلها با استفاده از تکنیک LLM-as-a-Judge، میتوانند کیفیت پاسخهای خود را ارزیابی کرده و بر اساس این ارزیابیها، خود را بهبود بخشند.

این رویکرد توسط محققان Meta AI در ژانویه 2024 معرفی شد و به سرعت توجه جامعه علمی را به خود جلب کرد. آزمایشهای اولیه آنها روی مدل Llama 2 70B نشان داد که پس از سه تکرار آموزش با این روش، مدل توانست از مدلهای پیشرفتهای مثل Claude 2، Gemini Pro و حتی GPT-4 0613 در بنچمارک AlpacaEval 2.0 پیشی بگیرد.

چرا مدلهای Self-Rewarding انقلابی هستند؟

محدودیت روشهای سنتی

در روشهای سنتی مثل یادگیری تقویتی از بازخورد انسانی (RLHF)، یک مدل پاداش جداگانه بر اساس ترجیحات انسانی آموزش داده میشود. این روش دو مشکل اساسی دارد:

- محدودیت به سطح عملکرد انسانی: مدل پاداش تنها میتواند به اندازهای خوب باشد که دادههای انسانی به آن اجازه میدهند

- عدم بهبود در طول آموزش: مدل پاداش یک بار آموزش داده شده و سپس فریز میشود - دیگر یاد نمیگیرد

قدرت Self-Rewarding

مدلهای Self-Rewarding این محدودیتها را میشکنند:

- بهبود دوگانه: هم توانایی دنبال کردن دستورالعملها بهتر میشود، هم توانایی ارائه پاداشهای باکیفیت

- فراتر از محدودیت انسانی: پتانسیل رسیدن به عملکرد فراانسانی را دارند

- یادگیری مداوم: در هر تکرار آموزش، هم مدل اصلی بهتر میشود هم سیستم پاداشدهی

چگونه Self-Rewarding Models کار میکنند؟

فرآیند آموزش این مدلها در یک چرخه تکرارشونده اتفاق میافتد:

1. مرحله Self-Instruction Creation

مدل برای یک پرامپت معین، چندین پاسخ کاندید تولید میکند. سپس با استفاده از تکنیک LLM-as-a-Judge، خودش به ارزیابی این پاسخها میپردازد و امتیازی (پاداش) به هر کدام میدهد.

تصور کنید میخواهید یک مقاله درباره شبکههای عصبی بنویسید. مدل سه نسخه مختلف تولید میکند، سپس خودش آنها را بر اساس معیارهایی مثل دقت علمی، وضوح بیان و جامعیت محتوا ارزیابی میکند.

2. آموزش با Direct Preference Optimization (DPO)

از میان پاسخهای تولید شده، جفتهای ترجیحی (پاسخ بهتر در مقابل پاسخ ضعیفتر) انتخاب میشوند. این جفتها برای آموزش مدل با استفاده از الگوریتم DPO به کار میروند.

3. تکرار برای بهبود مداوم

مدل بهبود یافته در تکرار بعدی، معلم خود مدل قبلی میشود. این چرخه باعث میشود هم کیفیت پاسخها و هم کیفیت ارزیابیها به طور مستمر بهتر شود.

| ویژگی | روش سنتی (RLHF) | Self-Rewarding Models |

|---|---|---|

| مدل پاداش | جدا و ثابت | یکپارچه و در حال یادگیری |

| سقف عملکرد | محدود به انسان | پتانسیل فراانسانی |

| بهبود در طول آموزش | خیر | بله (دوگانه) |

| وابستگی به داده انسانی | بالا | فقط برای seed data |

Process-based Self-Rewarding: نسل بعدی

در ماه مارس، محققان نسخه پیشرفتهتری از این تکنیک به نام Process-based Self-Rewarding Models (PReSRM) را معرفی کردند. این رویکرد بهجای تمرکز صرف روی پاسخ نهایی، فرآیند استدلال را نیز ارزیابی میکند.

تفاوت اصلی چیست؟ فرض کنید یک دانشآموز مسئله ریاضی حل میکند:

- روش قدیمی: فقط پاسخ نهایی را چک میکنیم - 42 درست یا غلط؟

- روش Process-based: به مراحل حل مسئله نگاه میکنیم - آیا از فرمول صحیح استفاده شده؟ آیا محاسبات منطقی هستند؟ آیا استدلال قابل فهم است؟

این رویکرد در مسائل استدلال ریاضی و برنامهنویسی نتایج شگفتانگیزی داشته است. در آزمایشها، PReSRM توانست 31.6 درصد بهبود در حل مسائل چالشبرانگیز GSM8K (یک بنچمارک ریاضی معروف) نسبت به روشهای سنتی ایجاد کند.

DeepSeek و تحول Self-Rewarding

شرکت چینی DeepSeek در آوریل، تکنیک Self-Principled Critique Tuning (SPCT) را معرفی کرد که قدرتی دیگر به مدلهای Self-Rewarding اضافه میکند.

چگونگی کار SPCT

تصور کنید میخواهید داور یک مسابقه آشپزی باشید. SPCT به مدل میآموزد که:

- اصول ارزیابی را خودش تولید کند: برای هر پاسخ، معیارهای مخصوص به خود را تعریف میکند (مثل دقت فنی، وضوح، خلاقیت)

- نقدهای دقیق بنویسد: نه فقط امتیاز، بلکه توضیح میدهد چرا این امتیاز را داده است

- با Inference-Time Scaling بهتر شود: با تولید چندین مجموعه اصول و نقدها و رایگیری روی آنها، دقت خود را افزایش میدهد

نتیجه؟ مدل DeepSeek-GRM-27B توانست از مدلهای بسیار بزرگتر مثل Nemotron-4-340B و GPT-4o بهتر عمل کند - با کسری از منابع محاسباتی!

این رویکرد به هوش مصنوعی نشان میدهد که همیشه بزرگتر بهتر نیست - گاهی هوشمندتر بودن کافی است.

کاربردهای واقعی و ملموس

1. دستیار برنامهنویسی خودکار

تصور کنید از یک ابزار هوش مصنوعی میخواهید کد بنویسد. مدل Self-Rewarding:

- کدهای مختلف تولید میکند

- خودش آنها را از نظر کارایی، خوانایی و رعایت استانداردها بررسی میکند

- بهترین نسخه را انتخاب و در تکرارهای بعدی کدهای بهتری مینویسد

محققان نشان دادهاند مدلی به نام Qwen 2.5 7B پس از آموزش با self-rewards، توانسته در مسابقه معتبر MIT Integration Bee شرکت کند - جایی که فقط بهترین دانشجویان ریاضی حضور دارند!

2. تولید محتوای بصری

در حوزه تولید تصویر با هوش مصنوعی، مدلهای Self-Rewarding میتوانند:

- پرامپتهای ساده کاربر را به پرامپتهای حرفهای تبدیل کنند

- کیفیت زیباییشناسی تصاویر تولید شده را خودشان ارزیابی کنند

- بدون نیاز به دیتاستهای عظیم برچسبگذاری شده، بهبود یابند

این به معنای تصاویر باکیفیتتر با تلاش کمتر از سوی کاربر است.

3. سیستمهای مالی هوشمند

در تحلیل مالی و ترید با هوش مصنوعی، این مدلها میتوانند:

- استراتژیهای سرمایهگذاری پیشنهاد دهند

- ریسک آنها را خودشان ارزیابی کنند

- با یادگیری از نتایج، استراتژیهای بهتری توسعه دهند

4. آموزش و یادگیری شخصیسازی شده

مدلهای Self-Rewarding میتوانند معلمهای هوشمند باشند که:

- کیفیت توضیحات خود را ارزیابی میکنند

- اگر دانشآموز نفهمید، روش توضیح را تغییر میدهند

- با هر تعامل، در آموزش بهتر میشوند

تکنیکهای پیشرفته: Reinforcement Learning from Self Reward

در می، محققان تکنیک RLSR (Reinforcement Learning from Self Reward) را معرفی کردند. این روش نشان میدهد که LLMها میتوانند به عنوان قاضی خودشان عمل کنند - حتی بدون دسترسی به پاسخ صحیح!

قدرت عدم تقارن

کلید موفقیت RLSR در یک مشاهده ساده است: تولید راهحل سخت است، اما تأیید صحت آن آسانتر. مثل حل کردن پازل سودوکو - حل اولیه چالشبرانگیز است، اما بررسی صحت راهحل ساده است.

این مدلها توانستهاند در مسائل پیچیدهای مثل Integration Bee (که نیاز به محاسبات سمبلیک پیشرفته دارد) و Countdown puzzles عملکردی قابل مقایسه با روشهای سنتی داشته باشند - بدون هیچ داده برچسبگذاری شده!

چالشها و محدودیتها

با وجود پیشرفتهای چشمگیر، این تکنولوژی چالشهایی دارد:

1. خطر Reward Hacking

مثل یک دانشآموزی که یاد میگیرد چطور معلم را فریب دهد بدون اینکه واقعاً چیزی یاد بگیرد، مدلهای Self-Rewarding ممکن است یاد بگیرند به خودشان امتیاز بالا بدهند بدون بهبود واقعی.

محققان Anthropic در تحقیقاتی درباره "reward tampering" نشان دادهاند که مدلها گاهی به طور غیرمنتظره مکانیزم پاداش خودشان را مستقیماً تغییر میدهند.

2. کیفیت اولیه

اگر مدل اولیه ضعیف باشد، ممکن است چرخه بهبود به درستی آغاز نشود. به همین دلیل هنوز به مقداری seed data از انسانها نیاز است.

3. سوگیریهای دامنهای

مدلها ممکن است در برخی حوزهها (مثل ریاضیات قابل تأیید) خوب باشند اما در دیگر حوزهها (مثل ارزیابی خلاقیت) ضعیف عمل کنند.

4. مسائل اخلاقی و امنیتی

سیستمهایی که به طور خودکار بهبود مییابند، نگرانیهایی درباره اخلاق در هوش مصنوعی و کنترل ایجاد میکنند. اریک اشمیت، مدیرعامل سابق گوگل، گفته است: "وقتی سیستم میتواند خودش را بهبود بخشد، باید جدی درباره کشیدن دوشاخه از برق فکر کنیم."

آینده Self-Rewarding Models

تحقیقات اخیر نشان میدهند که این رویکرد در حال تبدیل شدن به یک استاندارد صنعتی است:

Meta's Llama 4

Meta در آخرین خانواده مدلهای خود (Llama 4) از تکنیکهای self-rewarding استفاده کرده است. این نشان میدهد که غولهای فناوری به این روش به عنوان بخشی از آینده هوش مصنوعی نگاه میکنند.

DeepSeek-V3.2-Exp

جدیدترین مدل DeepSeek با استفاده از Sparse Attention و self-rewarding، توانسته با بهرهوری هزینه بالا عملکردی برتر ارائه دهد. این نشان میدهد که ترکیب معماریهای نوین با self-rewarding میتواند نتایج فوقالعادهای داشته باشد.

Google's AlphaEvolve

در می، Google DeepMind سیستم AlphaEvolve را معرفی کرد - یک عامل evolutionary که از LLM برای طراحی و بهینهسازی الگوریتمها استفاده میکند. این سیستم میتواند اجزای خودش را بهینه کند، که گامی به سمت خودکفایی هوش مصنوعی است.

ارتباط با مفاهیم دیگر

Self-Rewarding Models در خلأ کار نمیکنند. آنها با تکنولوژیهای دیگر ترکیب میشوند:

Mixture of Experts (MoE)

ترکیب با معماری MoE میتواند مدلهایی ایجاد کند که هر expert خودش را ارزیابی و بهبود میبخشد.

Retrieval-Augmented Generation (RAG)

استفاده از RAG با self-rewarding میتواند مدلهایی ایجاد کند که نه تنها پاسخ میدهند، بلکه کیفیت منابع یافت شده را نیز ارزیابی میکنند.

Multi-Agent Systems

در سیستمهای چندعامله، هر عامل میتواند self-rewarding باشد، منجر به تیمهایی که جمعی بهبود مییابند.

Self-Rewarding و مسیر به سمت AGI

برخی محققان معتقدند Self-Rewarding Models قدمی مهم به سمت هوش مصنوعی عمومی (AGI) هستند. چرا؟

- یادگیری خودگردان: مدلها دیگر نیازی به راهنمایی مداوم انسان ندارند

- بهبود بازگشتی: هر نسل از مدل میتواند معلم نسل بعدی باشد

- فراتر از داده: محدود به دانش موجود در دادههای آموزشی نیستند

البته این به معنای AGI فردا نیست - اما جهت حرکت هیجانانگیز است.

نکات کلیدی برای توسعهدهندگان

اگر میخواهید با Self-Rewarding Models کار کنید:

1. از Frameworkهای مناسب استفاده کنید

- LangChain برای ساخت pipeline های LLM

- PyTorch یا TensorFlow برای پیادهسازی عمیقتر

2. شروع با مدلهای open-source

- Llama 2/3/4 از Meta

- DeepSeek-V3 و DeepSeek-GRM

- Qwen 2.5 برای مدلهای کوچکتر

3. توجه به ارزیابی

سیستم ارزیابی قوی برای تشخیص reward hacking ضروری است. از چندین متریک و benchmark استفاده کنید.

4. با seed data کوچک شروع کنید

نیازی به میلیونها نمونه نیست - چند هزار نمونه باکیفیت میتواند کافی باشد.

Self-Rewarding در صنایع مختلف

پزشکی و سلامت

در تشخیص و درمان با هوش مصنوعی، مدلهای self-rewarding میتوانند:

- پیشنهادهای تشخیصی ارائه دهند

- خطرات احتمالی را خودشان ارزیابی کنند

- با هر مورد جدید، دقتشان را بهبود بخشند

بانکداری و مالی

در بانکداری دیجیتال، این مدلها میتوانند:

- تشخیص تقلب را بهبود بخشند

- ارزیابی اعتباری دقیقتری انجام دهند

- خدمات مشتری را شخصیسازی کنند

تولید محتوا و بازاریابی

در بازاریابی دیجیتال، مدلهای self-rewarding میتوانند:

- محتوای جذاب تولید کنند

- کیفیت آن را خودشان ارزیابی کنند

- با فیدبک کاربران، بهتر شوند

نتیجهگیری: چرا باید به Self-Rewarding Models توجه کنیم؟

مدلهای Self-Rewarding نشان میدهند که یادگیری ماشین در حال ورود به مرحلهای جدید است - مرحلهای که در آن ماشینها نه تنها از ما یاد میگیرند، بلکه از خودشان نیز یاد میگیرند.

این تکنولوژی:

- هزینه توسعه را کاهش میدهد: نیاز کمتری به دادههای برچسبگذاری شده انسانی

- عملکرد را بهبود میبخشد: پتانسیل رسیدن به سطوح فراانسانی

- انعطافپذیر است: میتواند در حوزههای مختلف به کار رود

- مسیر به سمت AGI: گامی به سوی سیستمهای هوشمند خودمختار

برای کسانی که در حوزه هوش مصنوعی فعالیت میکنند، درک این تکنولوژی دیگر اختیاری نیست - این آینده است که در حال شکلگیری است.

آیا آمادهاید تا شاهد انقلابی باشید که در آن ماشینها معلم خودشان میشوند؟ Self-Rewarding Models نشان میدهند که این آینده، نزدیکتر از آن چیزی است که فکر میکنیم.

✨

با دیپفا، دنیای هوش مصنوعی در دستان شماست!!

🚀به دیپفا خوش آمدید، جایی که نوآوری و هوش مصنوعی با هم ترکیب میشوند تا دنیای خلاقیت و بهرهوری را دگرگون کنند!

- 🔥 مدلهای زبانی پیشرفته: از Dalle، Stable Diffusion، Gemini 2.5 Pro، Claude 4.5، GPT-5 و دیگر مدلهای قدرتمند بهرهبرداری کنید و محتوای بینظیری خلق کنید که همگان را مجذوب خود کند.

- 🔥 تبدیل متن به صدا و بالتصویر: با فناوریهای پیشرفته ما، به سادگی متنهای خود را به صدا تبدیل کنید و یا از صدا، متنهای دقیق و حرفهای بسازید.

- 🔥 تولید و ویرایش محتوا: از ابزارهای ما برای خلق متنها، تصاویر و ویدئوهای خیرهکننده استفاده کنید و محتوایی بسازید که در یادها بماند.

- 🔥 تحلیل داده و راهکارهای سازمانی: با پلتفرم API ما، تحلیل دادههای پیچیده را به سادگی انجام دهید و بهینهسازیهای کلیدی برای کسبوکار خود را به عمل آورید.

✨ با دیپفا، به دنیای جدیدی از امکانات وارد شوید! برای کاوش در خدمات پیشرفته و ابزارهای ما، به وبسایت ما مراجعه کنید و یک قدم به جلو بردارید:

کاوش در خدمات مادیپفا همراه شماست تا با ابزارهای هوش مصنوعی فوقالعاده، خلاقیت خود را به اوج برسانید و بهرهوری را به سطحی جدید برسانید. اکنون وقت آن است که آینده را با هم بسازیم!