وبلاگ / شبکههای عصبی بازگشتی (RNN): معماری، کاربردها و چالشها

شبکههای عصبی بازگشتی (RNN): معماری، کاربردها و چالشها

مقدمه

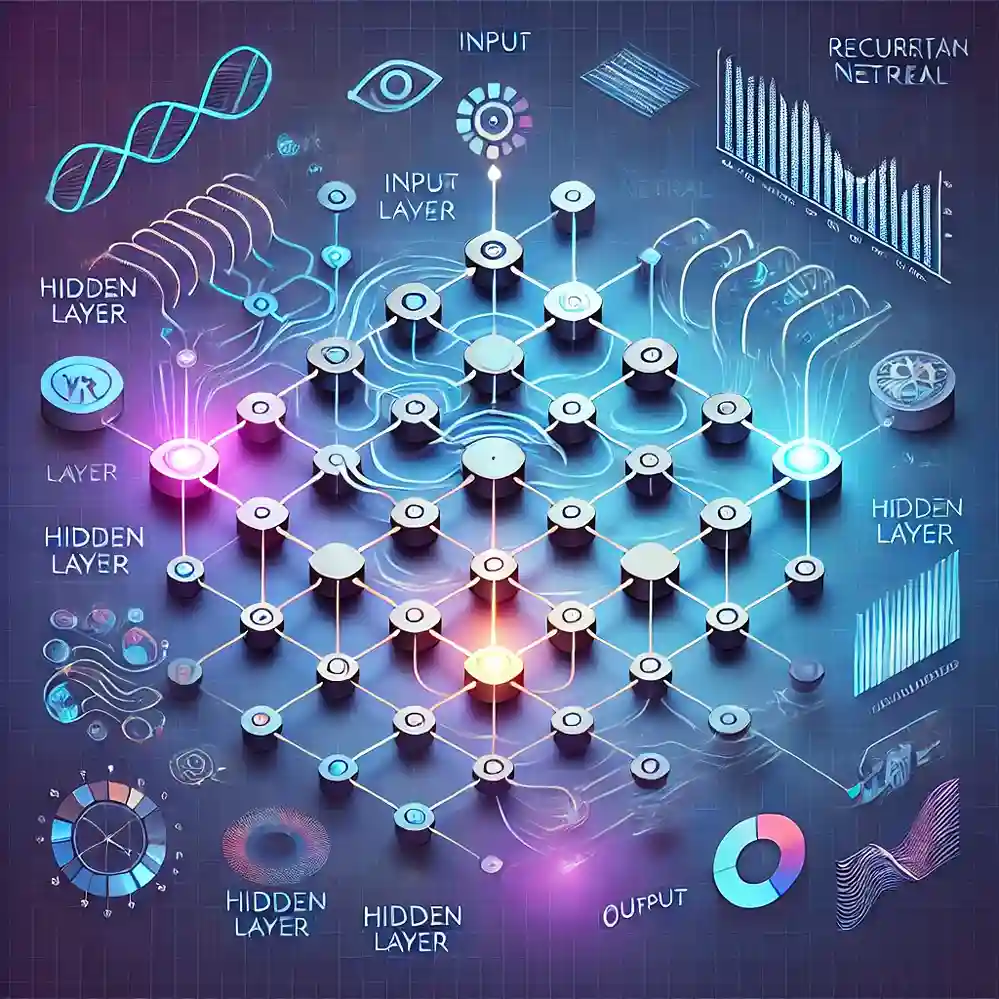

شبکههای عصبی بازگشتی (Recurrent Neural Networks یا RNN) یکی از معماریهای پیشرفته در حوزه یادگیری عمیق هستند که برای پردازش دادههای ترتیبی و سریهای زمانی طراحی شدهاند. بر خلاف شبکههای عصبی کلاسیک که ورودیها را به طور مستقل پردازش میکنند، RNNها با استفاده از حافظه داخلی خود قادر به یادگیری وابستگیها و روابط بین دادههای متوالی هستند. این ویژگی باعث شده که این مدلها در کاربردهایی نظیر پردازش زبان طبیعی (NLP)، تشخیص صدا، و تحلیل دادههای سری زمانی مورد استفاده قرار گیرند.

در این مقاله، به معرفی معماری RNN، کاربردها، مزایا، معایب و چالشهای این مدل میپردازیم.

معماری شبکه عصبی بازگشتی

1. ساختار اصلی RNN

شبکههای عصبی بازگشتی به گونهای طراحی شدهاند که اطلاعات ورودی قبلی را برای پردازش دادههای بعدی نگه میدارند. این ویژگی به کمک حلقه بازگشتی (Recurrent Loop) ممکن میشود. در هر زمان، RNN از وضعیت فعلی و وضعیت قبلی خود برای محاسبه خروجی استفاده میکند.

فرمول اصلی RNN به صورت زیر است:

که در آن:

که در آن:

- : وضعیت پنهان در زمان

- : وضعیت پنهان در زمان قبلی

- : ورودی در زمان

- و : ماتریسهای وزن

- : بایاس

- : تابع فعالسازی

2. انواع RNN

RNNها بسته به نوع ورودی و خروجی به چند دسته تقسیم میشوند:

- One-to-One: مناسب برای دادههای غیرترتیبی مانند طبقهبندی تصاویر.

- One-to-Many: برای تولید متن یا موسیقی.

- Many-to-One: برای تحلیل احساسات یا طبقهبندی توالیها.

- Many-to-Many: برای ترجمه زبان یا پردازش ویدئو.

3. مشکل محو شدن گرادیان (Vanishing Gradient Problem)

یکی از مشکلات اصلی RNN، محو شدن گرادیان است که باعث میشود مدل نتواند وابستگیهای طولانیمدت را یاد بگیرد. برای حل این مشکل، معماریهایی مانند LSTM و GRU توسعه داده شدهاند.

مزایای RNN

1. پردازش دادههای ترتیبی

RNNها توانایی فوقالعادهای در یادگیری روابط زمانی و ترتیبی دارند. این ویژگی باعث شده که در کاربردهایی نظیر تحلیل سریهای زمانی و پردازش زبان طبیعی بسیار موثر باشند.

2. اشتراک وزنها

به دلیل استفاده از وزنهای مشترک در تمام گامهای زمانی، تعداد پارامترهای RNN در مقایسه با مدلهای دیگر کمتر است. این موضوع به کاهش پیچیدگی محاسباتی کمک میکند.

3. انعطافپذیری بالا

RNNها به راحتی میتوانند در مسائل مختلفی مانند پیشبینی، تولید داده، و ترجمه زبان استفاده شوند.

کاربردهای RNN

1. پردازش زبان طبیعی (NLP)

RNNها نقش اساسی در پردازش زبان طبیعی دارند. آنها برای تحلیل متن، ترجمه زبان، تولید متن، و تشخیص احساسات به کار میروند.

2. تشخیص گفتار

RNNها در تحلیل و تشخیص گفتار، تبدیل گفتار به متن و پردازش صداهای پیچیده استفاده میشوند.

3. تحلیل سریهای زمانی

یکی از کاربردهای مهم RNN، تحلیل و پیشبینی سریهای زمانی است. برای مثال، پیشبینی قیمت سهام، دادههای آبوهوا، و تحلیل فروش از جمله کاربردهای این مدل است.

4. سیستمهای توصیهگر

RNNها برای پیشنهاد محتوا در سیستمهای توصیهگر، مانند پیشنهاد فیلم، موسیقی یا کتاب، استفاده میشوند. این مدلها میتوانند بر اساس رفتار قبلی کاربران پیشنهادهای دقیقتری ارائه دهند.

5. رباتیک و کنترل

RNNها در کنترل سیستمهای پیچیده و رباتها به کار میروند. توانایی مدل در یادگیری وابستگیهای زمانی به بهبود عملکرد سیستمهای کنترلی کمک میکند.

چالشها و محدودیتهای RNN

1. محو شدن و انفجار گرادیان

RNNها به دلیل استفاده از حلقههای بازگشتی، با مشکلاتی مانند محو شدن یا انفجار گرادیان مواجه میشوند که میتواند فرآیند آموزش را مختل کند.

2. نیاز به دادههای زیاد

مانند بسیاری از مدلهای یادگیری عمیق، RNNها نیز به دادههای بزرگی برای آموزش نیاز دارند. کمبود داده میتواند دقت مدل را کاهش دهد.

3. مشکلات محاسباتی

آموزش RNNها زمانبر و پیچیده است. این مدلها نیازمند منابع محاسباتی بالایی هستند که ممکن است در برخی موارد محدودکننده باشد.

4. عدم یادگیری وابستگیهای طولانیمدت

RNNهای ساده در یادگیری وابستگیهای طولانیمدت مشکل دارند. این مسئله در کاربردهایی که اطلاعات گذشته به شدت بر خروجی تأثیر میگذارد، محدودکننده است.

راهکارهای بهبود RNN

برای غلبه بر محدودیتهای RNN، راهکارهای مختلفی ارائه شده است:

- استفاده از LSTM و GRU: این معماریها به طور خاص برای رفع مشکلات محو شدن گرادیان طراحی شدهاند.

- عادیسازی گرادیان (Gradient Clipping): این روش برای جلوگیری از انفجار گرادیان استفاده میشود.

- استفاده از تکنیکهای تنظیم مدل: روشهایی مانند Dropout و Batch Normalization میتوانند عملکرد مدل را بهبود بخشند.

نتیجهگیری

شبکههای عصبی بازگشتی (RNN) یکی از معماریهای قدرتمند در یادگیری عمیق هستند که به دلیل توانایی در یادگیری وابستگیهای زمانی، جایگاه ویژهای در تحلیل دادههای ترتیبی دارند. با این حال، مشکلاتی مانند محو شدن گرادیان و نیاز به منابع محاسباتی بالا، چالشهایی را برای استفاده از این مدلها ایجاد کرده است.

با پیشرفت معماریهای پیشرفتهتر مانند LSTM و GRU و استفاده از روشهای بهینهسازی، RNNها همچنان یکی از ابزارهای اصلی در هوش مصنوعی و یادگیری عمیق باقی ماندهاند.

✨

با دیپفا، دنیای هوش مصنوعی در دستان شماست!!

🚀به دیپفا خوش آمدید، جایی که نوآوری و هوش مصنوعی با هم ترکیب میشوند تا دنیای خلاقیت و بهرهوری را دگرگون کنند!

- 🔥 مدلهای زبانی پیشرفته: از Dalle، Stable Diffusion، Gemini 2.5 Pro، Claude 4.5، GPT-5 و دیگر مدلهای قدرتمند بهرهبرداری کنید و محتوای بینظیری خلق کنید که همگان را مجذوب خود کند.

- 🔥 تبدیل متن به صدا و بالتصویر: با فناوریهای پیشرفته ما، به سادگی متنهای خود را به صدا تبدیل کنید و یا از صدا، متنهای دقیق و حرفهای بسازید.

- 🔥 تولید و ویرایش محتوا: از ابزارهای ما برای خلق متنها، تصاویر و ویدئوهای خیرهکننده استفاده کنید و محتوایی بسازید که در یادها بماند.

- 🔥 تحلیل داده و راهکارهای سازمانی: با پلتفرم API ما، تحلیل دادههای پیچیده را به سادگی انجام دهید و بهینهسازیهای کلیدی برای کسبوکار خود را به عمل آورید.

✨ با دیپفا، به دنیای جدیدی از امکانات وارد شوید! برای کاوش در خدمات پیشرفته و ابزارهای ما، به وبسایت ما مراجعه کنید و یک قدم به جلو بردارید:

کاوش در خدمات مادیپفا همراه شماست تا با ابزارهای هوش مصنوعی فوقالعاده، خلاقیت خود را به اوج برسانید و بهرهوری را به سطحی جدید برسانید. اکنون وقت آن است که آینده را با هم بسازیم!